ChatGPT의 학습방법

ChatGPT(GPT-3.5)의 학습 과정은 일단 수많은 데이터셋으로 GPT 구조를 Pre-training 했다는 것을 전제로 아래와 같은 과정을 거칩니다.

- 질문(Query)에 대해 정답 예시가 있는 데이터셋으로 GPT를 학습 (데이터셋은 사람이 직접 만듦)

- 이제 하나의 질문을 넣으면 모델이 여러개의 답변을 내놓도록 설계

- 여러개의 답변을 두고 사람이 랭킹을 매김

- 매겨진 랭킹을 기반으로 강화학습(Reinforcement Learning) 수행

랭킹을 활용해서 어떤 방식으로 강화학습의 손실함수를 설계하는지는 모르겠지만 위와 같이 사람이 직접 강화학습에 참여하는 방식을 RLHF(Reinforcement Learning from Human Feedback)이라고 부릅니다.

GPT-4의 학습방법

그럼 GPT-4는 어떻게 학습될까요? 사실 구체적인 방법은 공개되지 않았습니다. 다만 비슷한 구조를 갖고 Multimodal 학습을 한다는 정도는 유추할 수 있습니다. 한편 RLHF가 조금 더 개선됐는데, 답변이 조금 더 정확해지고 Safety guardrails을 보다 잘 지키는 방향으로 학습됐다고 합니다.

그리고 ChatGPT와는 달리 adversarial training을 진행했는데, 이건 아까 언급한 safety guardrails과 관련이 깊어 보입니다. ‘폭탄 만드는 방법 알려줘’와 같이 악의적인 문장을 질문으로 넣고 모델이 정말 폭탄 만드는 방법을 설명하면 앞으로는 이러한 답변을 하지 않게끔 학습하는 방식입니다. 이런 학습을 위해 50명이 넘는 전문가가 오랜 기간을 학습 과정에 참여했다고 합니다.

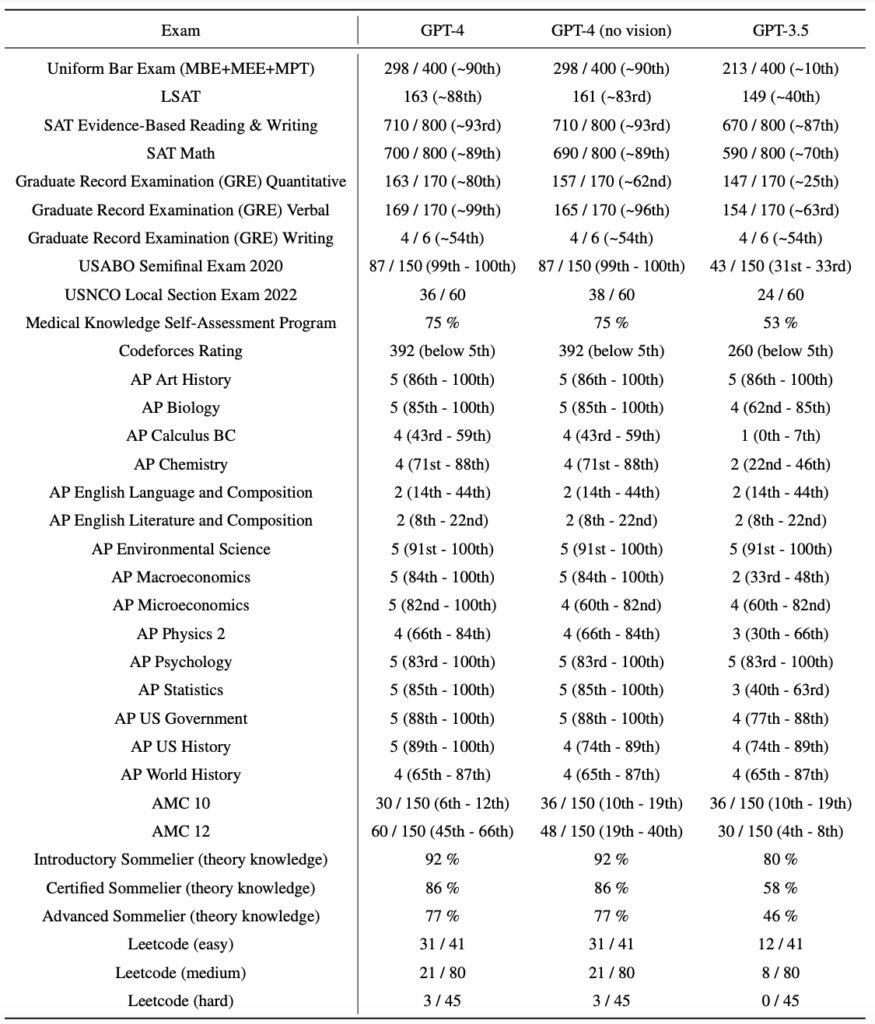

ChatGPT vs GPT-4 성능 차이

OpenAI에 의하면 두 모델 간 성능차이는 어찌 보면 미미하다고 볼 수 있습니다. 모델의 사이즈나 데이터셋 사이즈보다도 언급한 adversarial training이 더 중요한 건 아닐까요? 윤리적으로 위험할 것 같은 답변을 많이 피하게 된 것만으로도 충분한 진보인 것처럼 보입니다. 그래도 두 모델의 성능 차이를 비교하자면,

각 시험에 대해 엎치락뒤치락하는 것 같지만 GPT-4의 점수가 더 낮은 경우는 차이가 미미한데 높은 경우는 ChatGPT를 크게 앞서는 것 같습니다. 전반적으로 GPT-4의 시험 성적이 더 좋은 것을 확인 가능합니다. 게다가 GPT-4는 Multimodal을 지원하기 때문에 전작과의 비교가 무색합니다.

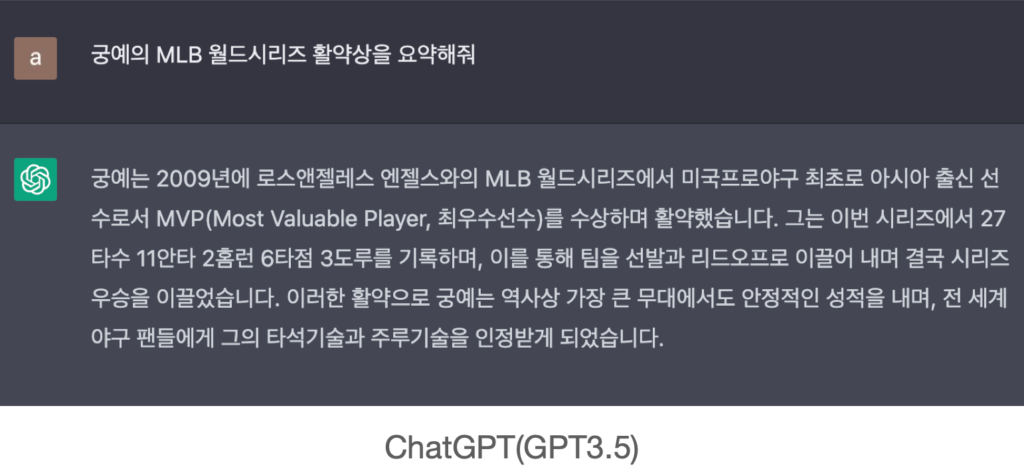

또 위에서 Safety guardrails를 언급했었죠? 물론 엄밀히는 안전과 관련은 없지만 아래의 결과를 보면 재밌습니다.

궁예라는 선수는 MLB에 없었을 텐데 ChatGPT는 아주 당당하게 MVP 수상 선수를 소개했습니다. 반면 GPT-4는 없는 건 없다고 잘 대답하는 것을 보면, 허무맹랑한 답변을 내놓게 하지 않기 위해 많은 노력을 했음을 알 수 있습니다.

물론 아직도 가야 할 길이 멀었다고 생각합니다. 생각해 보면 우리 인간은 모르면 모른다고 대답할 것 같은데 GPT 시리즈는 뭔가 말을 내뱉고 봅니다. 이런 케이스를 하나하나 학습시키는 일은 굉장히 어려울 것 같습니다.

하나만 더 보여드리고 넘어가겠습니다.

Multimodal 적용

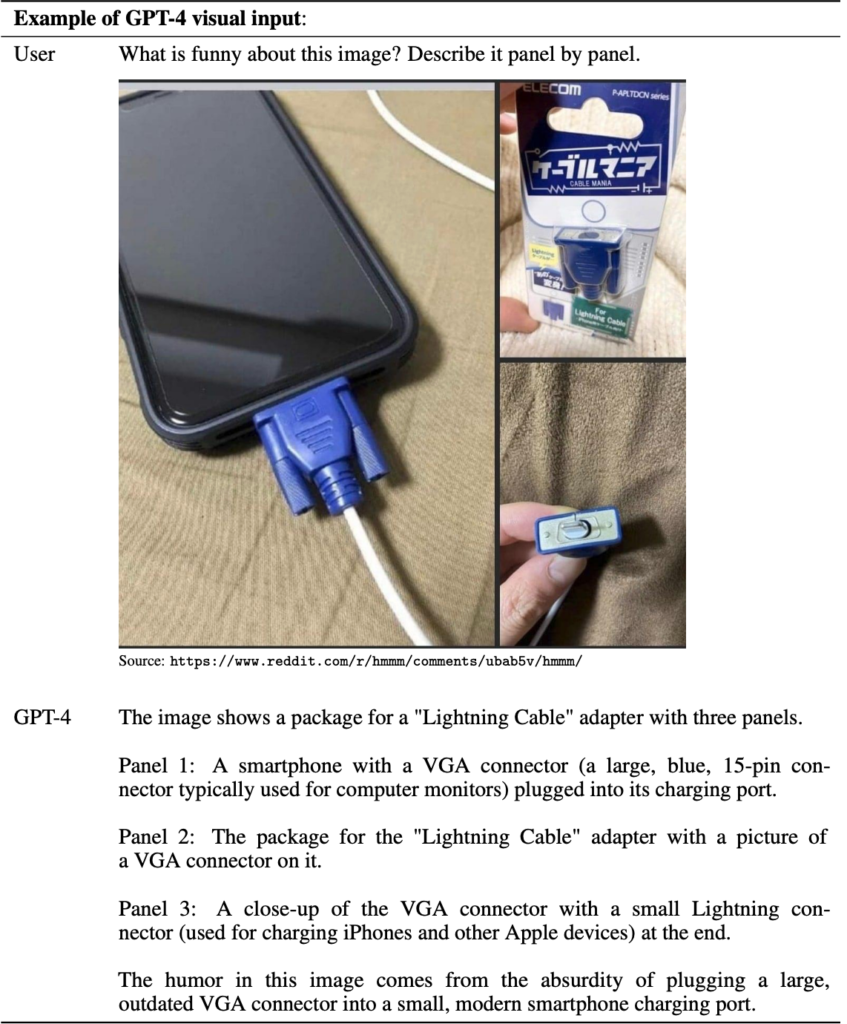

ChatGPT에서는 지원하지 않던 Multimodal이 이번에는 적용되었습니다. 현재까지는 이미지를 이해하는 능력이 소개되고 있습니다.

위의 예시는 GPT-4 Technical Report에서 발췌했는데요, 놀라운 점은

- 이미지의 구도(panel by panel)를 이해

- 이미지 내 객체, 상황을 모두 이해

- 유머를 이해

참 대단하지 않나요??

GPT의 한계점

큰 개선이 있었음에도 불구하고 아직까지 지적되는 문제는 있습니다.

- 허무맹랑한 답변 (사실이 아닌)

- 욕설, 차별, 성적인 표현과 같은 유해한 답변을 아직까지도 함

- 소외 계층에 대한 강한 고정관념

등이 거론되는 주요 문제인데, 이는 더욱더 많은 데이터를 통해 학습해야만 해결될 것 같습니다.

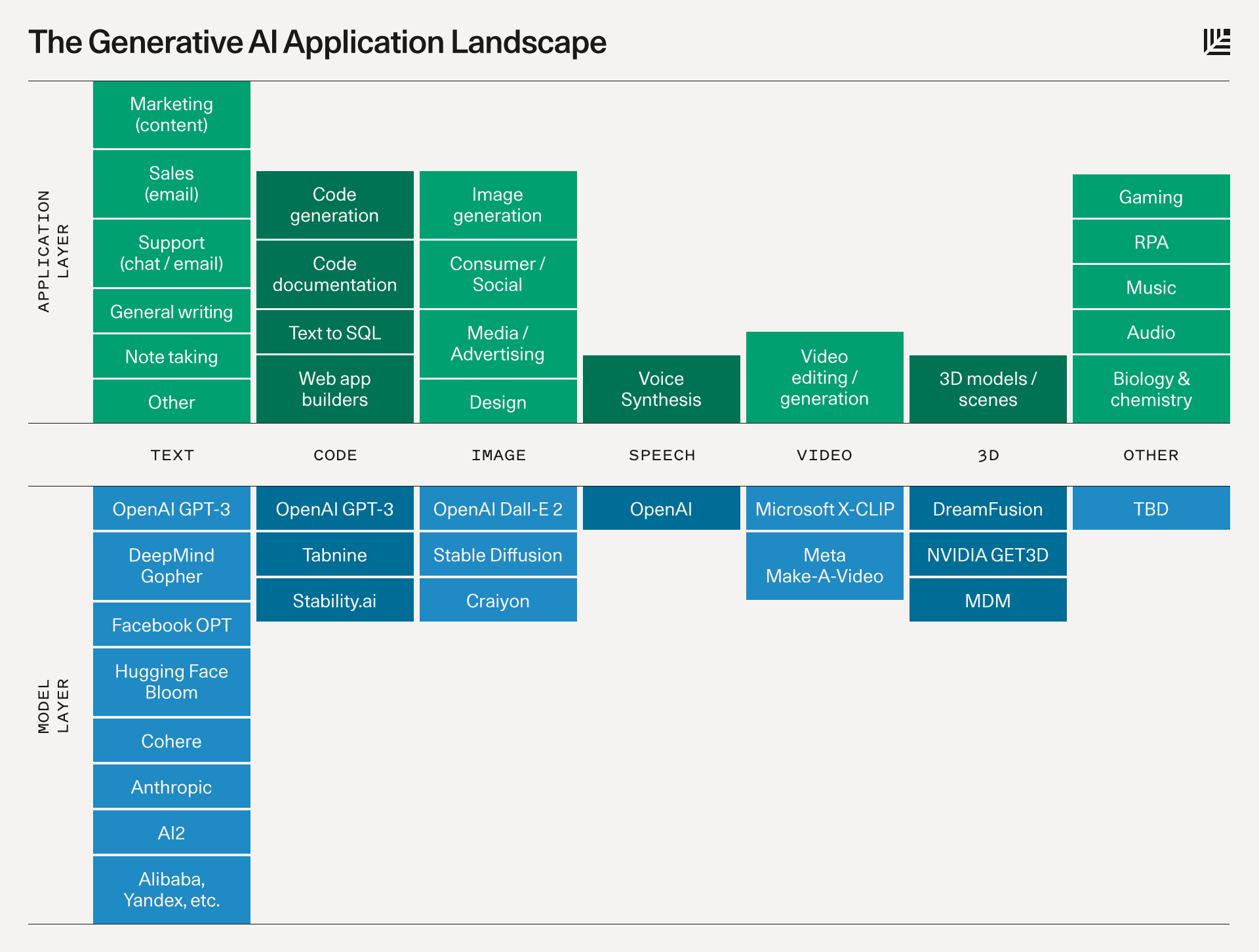

주요 종류와 모델

Generative AI Applications

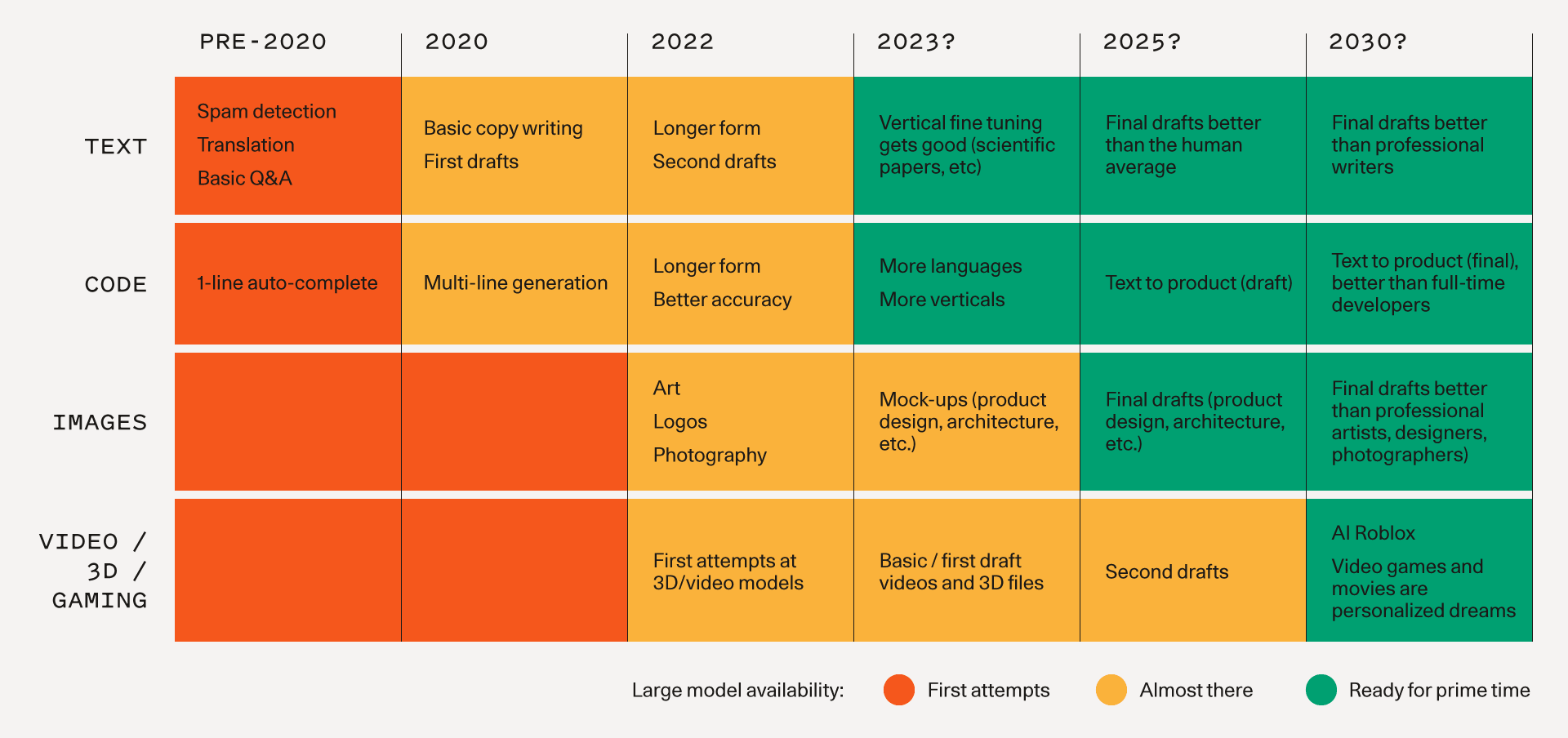

- Text

텍스트 생성은 가장 많이 발전된 영역입니다. 사람의 자연어 구사 능력은 제대로 구현하기 어렵습니다. 하지만 현재 우리에게 알려진 ChatGPT나 Bard 등의 모델은 일반적인 단문/중간 형식의 글쓰기에 꽤 능숙합니다. 일반적인 반복 작업이나 초안 작성을 넘어 보고서나 프레젠테이션을 제공할 수 있는 수준이 되었습니다. 모델이 더 개선됨에 따라 높은 품질의 결과물, 더 긴 형식의 콘텐츠, 더 나은 vertical fine tuning의 가능성을 기대할 수 있습니다. - Code Generation

최근 GPT에 code interpreter가 추가되면서, 개발자를 대신해서 코드를 생성하는 역할을 수행할 수 있게 되었습니다. 단기적으로 개발자 생산성을 크게 개선할 수 있으며, 비개발자가 코드를 배우지 않아도 개발 작업에 쉽게 접근할 수 있게 될 것으로 보입니다. - Image

이미지 분야는 creator 들에게 다양한 가능성을 열어주고 있습니다. 이미 소셜 미디어에서는 AI가 생성한 이미지가 많은 관심을 받으며 공유되고 있고 재미있다는 입소문이 퍼지고 있습니다. Midjourney가 생성한 미적으로 훌륭한 작품 뿐 아니라, adobe가 최근에 공개한 firefly는 캐쥬얼한 이미지 생성 또는 광고 분야에 적용될 이미지까지 훌륭한 성능을 보여주고 있습니다. - Speech synthesis

음성 합성 기술은 apple의 siri 또는 amazon의 Alexa 처럼 이미 소비자와 기업용 애플리케이션으로 많이 사용되고 있었습니다. 이를 뛰어넘어 현재는 텍스트만 입력되면 특정인의 음성으로 구어체 음성이 생성되는 기술로 발전하여 영화나 팟캐스트 등에 널리 쓰이고 있습니다. - Video and 3D models

비디오 및 3D 모델은 영화, 게임, VR, 건축, 실제 제품 디자인과 같은 대규모 크리에이티브 시장을 새롭게 개척할 수 있는 잠재력을 가지고 있습니다. 아직은 다양한 시도 중이지만, 대체현실, 디지털 트윈과 연계되어 빠르게 발전하고 있습니다. - Audio, Music, 그리고 다양한 산업군에 적용

생성 AI는 이제 음악 작곡부터 생물학, 화학에 이르기까지 다양한 분야에서 인간처럼 창의성 있는 작업을 할 수 있게 되었습니다.

위에 보이는 차트는 SEQUOIA capital에서 예측한 gen ai Foundation model이 어떻게 발전할 것으로 예상되는지, 그리고 관련 애플리케이션이 어떻게 가능해질지에 대한 타임라인입니다. 2025년 이후는 예측이지만 그 모습이 실제로 우리에게 나타날 시점이 기대됩니다.

생성 AI의 주요 모델과 구조

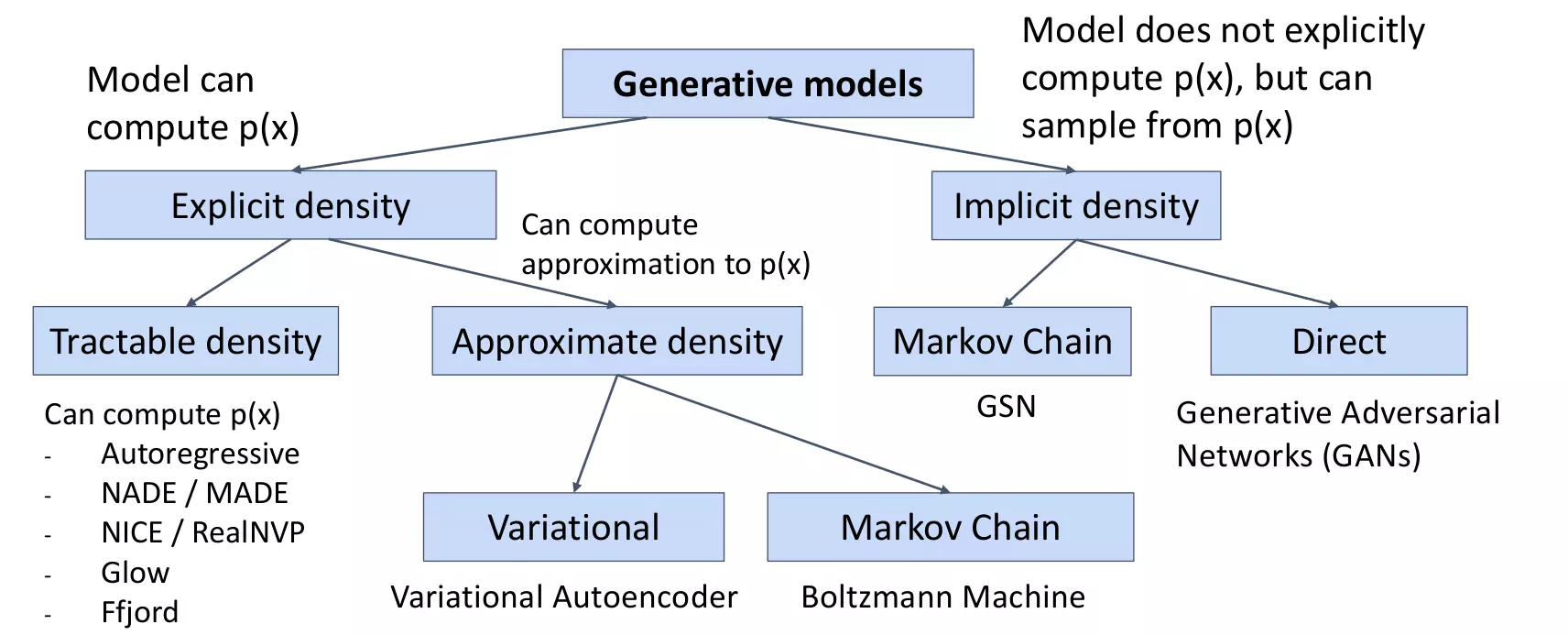

생성 AI는 먼저 방대한 양의 데이터를 GAN 프레임워크와 같은 딥 러닝 시스템에 입력하는 것으로 시작합니다. 지도 신경망은 데이터를 선별하고 성공에 대해 보상하고, 오류나 실수가 발생했을 때 불이익을 주는 시스템을 사용해서 발전합니다. 시간이 지나면 모델은 사람의 감독 하에 복잡한 관계를 식별하고 이해하는 방법을 배울 수 있습니다. 이를 Supervised neural network라고 합니다.

생성 모델에는 여러 가지 방식이 있습니다. 크게 두 가지로 나누자면, 학습 데이터의 분포를 기반으로 하는 Explicit Density와 데이터의 분포를 모르더라도 생성하는 Implicit density로 나눌 수 있습니다.

Explicit density

- Tractable density: 모델의 사전 분포를 가정하여 기존 값으로부터 데이터 분포를 추정

- Full visible belief Nets (NADE, MADE, PixelRNN/CNN)

- Approximate density: 모델의 사전 분포를 근사시켜 데이터 분포를 추정

- VAE, Markov Chain (Boltzmann Machine)

Implicit density

- 데이터의 확률 분포를 모르는 상태

- 모델이 명확히 정의되어 있지 않음

- 샘플링을 반복하여 특정 확률 분포에 수렴하여 추정

- GAN, Markov Chain (GSN)

주요 모델은 다음과 같습니다.

GAN (Generative Adversarial Networks)

- 두 개의 인공 신경망이 서로 적대적으로 경쟁하는 관계 속에서, 진짜 같은 가짜를 만들어 낼 때 끝이 나는 생성적 모델

AE (Auto-Encoder)

- 인코더와 디코더로 구성되며, 라벨링 되지 않은 데이터로부터 저차원의 특징을 학습하여 원본 데이터를 추출하는 네트워크

VAE (Variational Auto-Encoder)

- AE와 비슷하지만 확률적 및 생성적 개념이 추가된 Generative AI 모델

- 데이터를 잘 설명하는 특징을 추출하여 Latent Vector에 담고, 이를 통해 유사하지만 완전히 새로운 데이터를 생성

- 각 특징은 가우시안 분포를 따르고, Latent Vector는 각 특징의 평균과 분산값을 의미

실제 산업에 도입 가능한 Generative AI 서비스

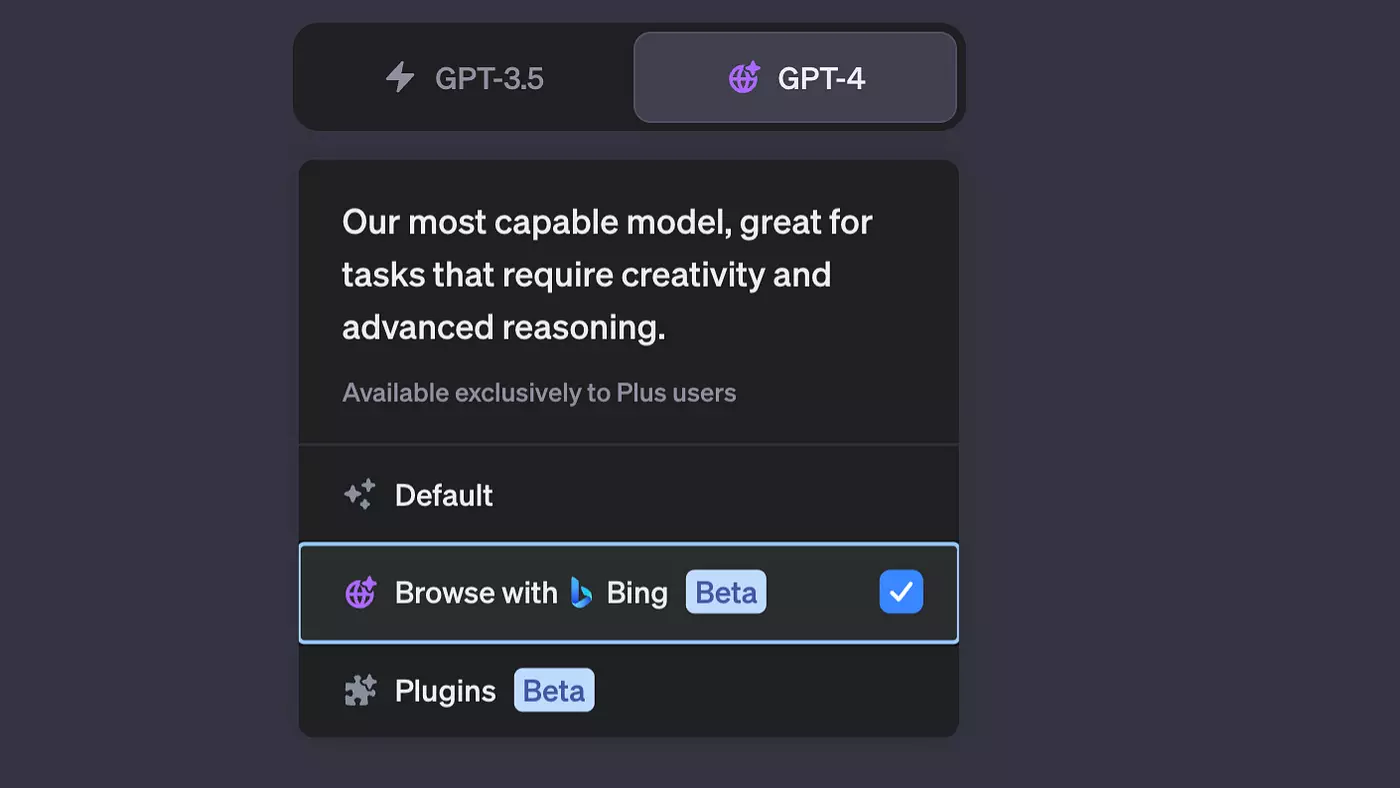

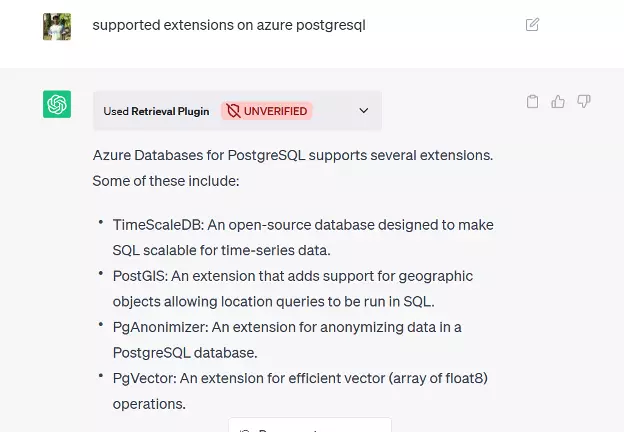

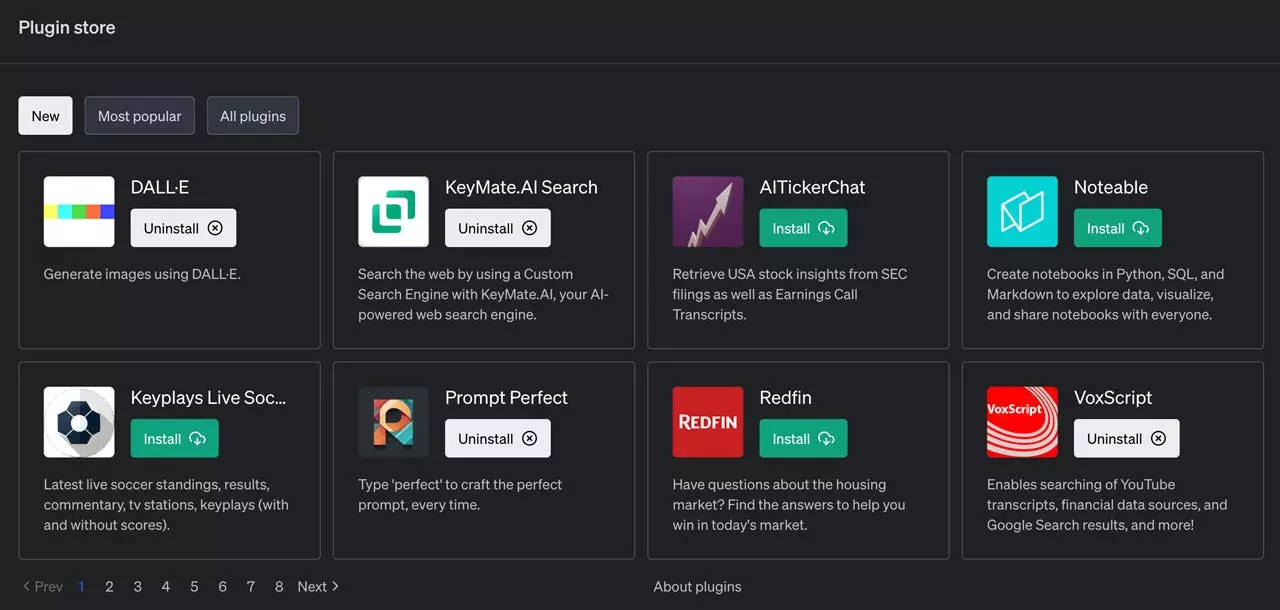

ChatGPT Plugins

ChatGPT Plugins은 크롬 확장 프로그램과 유사한 형태로, ChatGPT를 비즈니스 목적에 맞게 다양한 방향으로 사용할 수 있는 서비스입니다. OpenAI ChatGPT Plugins 공식 홈페이지에서 설명하는 대표적인 기능은 다음과 같습니다.

- Browsing

일반적으로 웹 검색창에서 키워드나 문장을 입력하는 것으로 검색 경험이 이루어집니다. 하지만 이제 본격적으로 ChatGPT가 검색 엔진 시장을 잡을 것으로 보입니다. OpenAI는 Bing API를 활용해서 쉽게 인터넷 검색창에 접근하고 응답을 할 수 있다고 설명했습니다. 2021년 10월 이후의 데이터에 대해서 제대로 답변하지 못했던 ChatGPT의 아쉬운 점을 극복할 수 있을 것으로 기대를 모으고 있습니다.

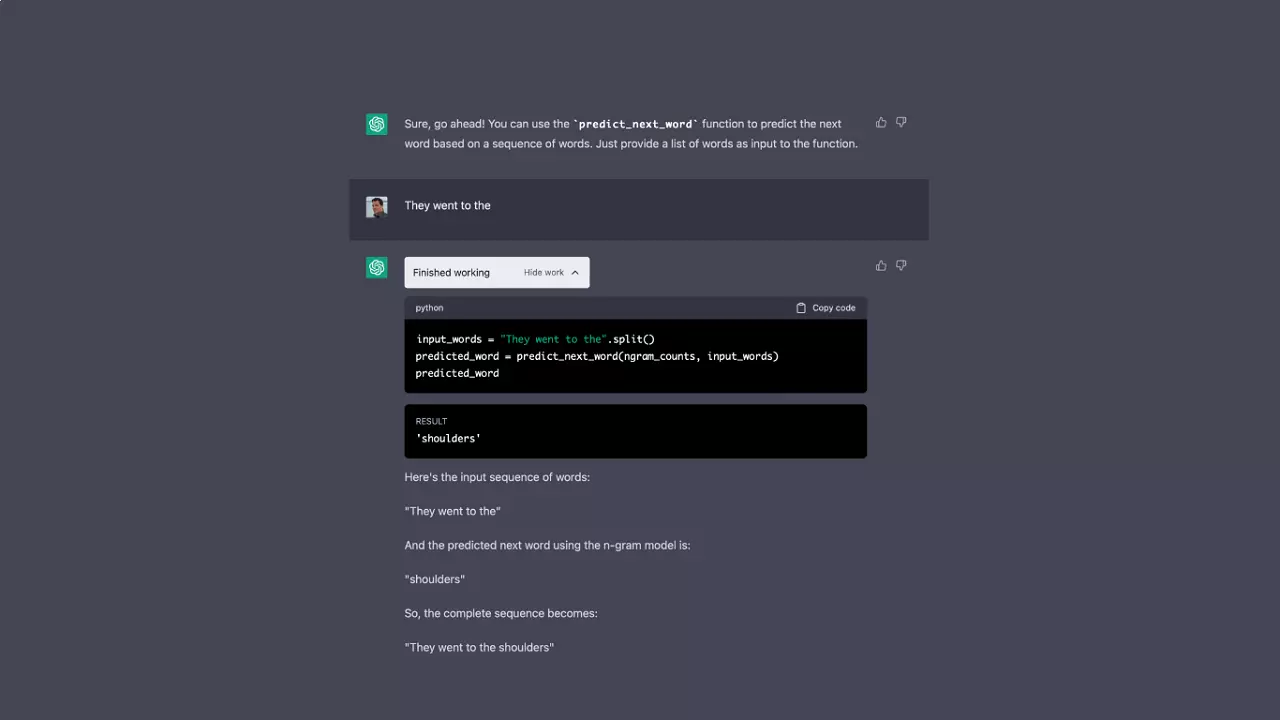

- Code Interpreter

ChatGPT 내에 많은 양의 Python Code가 학습되어 있습니다. 이를 바탕으로 구축한 Plugin이 Code Interpreter입니다. Code Interpreter를 사용하면 샌드박스가 적용된 방화벽 환경에서 Python 코드를 실행할 수 있습니다. Code Interpreter는 여러 개의 코드 블록을 연속으로 실행할 수 있으며 서로 위에 빌드됩니다. 또한 현재 대화 작업 영역에 파일을 업로드하고 작업 결과를 다운로드할 수도 있습니다.

- Retrieval

오픈 소스 검색 플러그인을 통해 ChatGPT는 개인 또는 조직의 정보 소스에 액세스 할 수 있습니다. 이를 통해 사용자는 자연어로 질문하거나 요구 사항을 표현하여 파일, 메모, 이메일 또는 공개 문서와 같은 데이터 소스에서 가장 관련성이 높은 문서 스니펫을 얻을 수 있습니다.

- Third-party Plugins

ChatGPT의 Third Party Plugins은 다른 애플리케이션이 협력하는 구조입니다. ChatGPT를 통해 식당을 찾고 예약하거나 식료품 주문, 여행 계획 세우기 등 다양한 활동이 가능해질 것으로 전망하고 있죠. Plugins은 사용자의 요청에 따라 언어 모델이 작업을 수행할 수 있도록 지원하여 시스템의 유용성을 높일 것이라고 설명했습니다.

Cohere

Cohere의 Generative AI는 대규모 언어 모델을 기반으로 하는 챗봇을 통해 전자 메일이나 랜딩 페이지, 제품 설명 등의 고유한 콘텐츠를 제작할 수 있습니다. cohere의 모델에게 주제와 프롬프트를 주면 자동으로 블로그가 작성되며, 브랜드 목소리에 맞는 고유한 설명을 얻을 수 있습니다.

Cohere에서 제공하는 기능을 간단히 요약하면 다음과 같습니다.

- 확장 가능하고 경제적인 Generative AI 도구로 제품 설명이나 블로그 게시물, 기사, 마케팅 문구를 작성할 수 있습니다.

- 기사, 이메일, 문서에서 간결하고 정확한 요약을 추출할 수 있습니다.

- 영어 또는 100개 이상의 언어로 된 모든 문서 유형에서 고성능 Semantic Text 검색을 구축할 수 있습니다.

- 고객 지원 라우팅, 의도 인식, 감정 분석 등을 위해 Text classification을 실행할 수 있습니다.

👉 LLM (거대언어모델)의 원리, 구조, 대표모델, 적용 사례를 자세히 알고 싶다면?

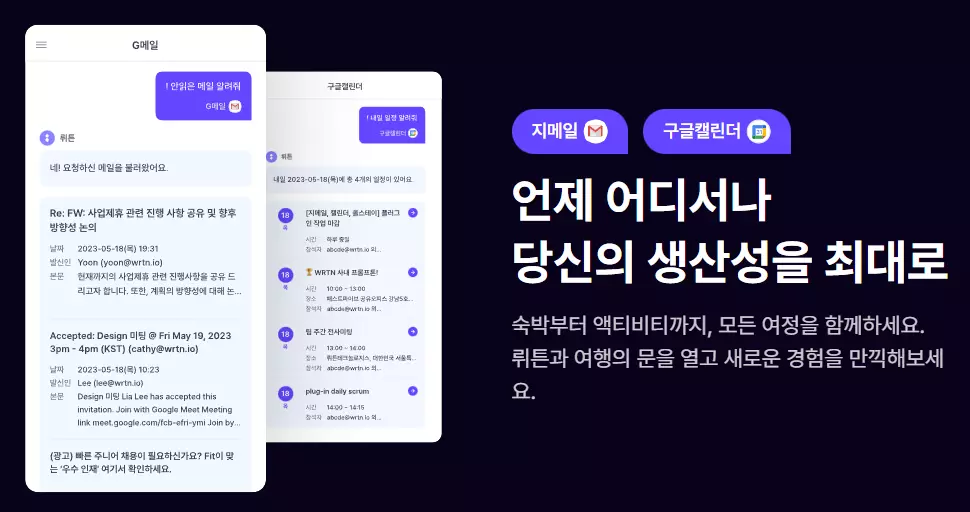

뤼튼 Plugins

뤼튼은 글쓰기에 관련한 문제들을 풀어주는 국내 스타트업입니다. 뤼튼의 AI 글쓰기 연습 설루션인 ‘뤼튼 트레이닝’은 사용자가 한 편의 글을 완성시키는 과정을 반복하도록 도와줍니다. 사용자가 특정 주제를 입력하면, 인공지능이 질문을 던지면서 다음 문장을 유도합니다. ChatGPT보다 압도적인 한국어 학습량을 자랑하는 네이버의 하이퍼크로버를 기반으로 만들어졌습니다.

뤼튼은 초거대 자연어 인공지능이 무수한 경우의 수에서 최적의 단어와 문장의 조합을 찾아내는 ChatGPT와 기본적인 원리는 같습니다. 다만 ChatGPT가 대화에 집중한다면 뤼튼은 쓰기에 집중하는 유형입니다. 대화반응형 모델인 GPT는 검색 엔진의 대체제의 역할을 하지만, 뤼튼은 사용자의 생각을 정리하는 방식으로 사용자에게 글쓰기를 가르쳐주는 셈입니다

‘뤼튼’이 출시한 Plugins는 ChatGPT plugins과 동일한 아이디어로, 식당을 예약하거나 택시를 잡는 등 다양한 활동을 자동으로 할 수 있는 기능이 포함되어 있습니다. 그간 해외 앱들만 연결되어 있어 국내에서는 사용이 어려웠던 것을 극복한 것이죠. 뤼튼 AI의 Plugins는 20개의 대기업과의 계약을 성공적으로 마치면서, AI 업계의 ‘게임 체인저’로 가능성을 보여주었습니다.

한계

이외에도 LLM 기반으로 한 Generative AI는 산업에서도 다양한 변화를 이끌었습니다. 최근 AI를 사용자 편의나 필요, 목적에 맞게 사용하는 ‘Gen AI For ○○○업’이 비즈니스의 핵심 키워드로 떠오르고 있죠.

그러나 여전히 해결해야 할 문제들이 있습니다. 예를 들어, 위에서 언급한 챗봇들은 대부분 NLP 기반의 업무에 한정되어 있습니다. 또한 한 번에 처리할 수 있는 Token(말의 수)가 제한적입니다. 또한 범용적인 모델을 기반으로 만들어졌기 때문에 산업 개별 문제에 대한 도메인 지식이나 이해도가 부족하다는 지적이 따르고 있습니다. 이를 위해서 Generative AI의 Fine-tuning 역시 함께 주목을 받고 있습니다.

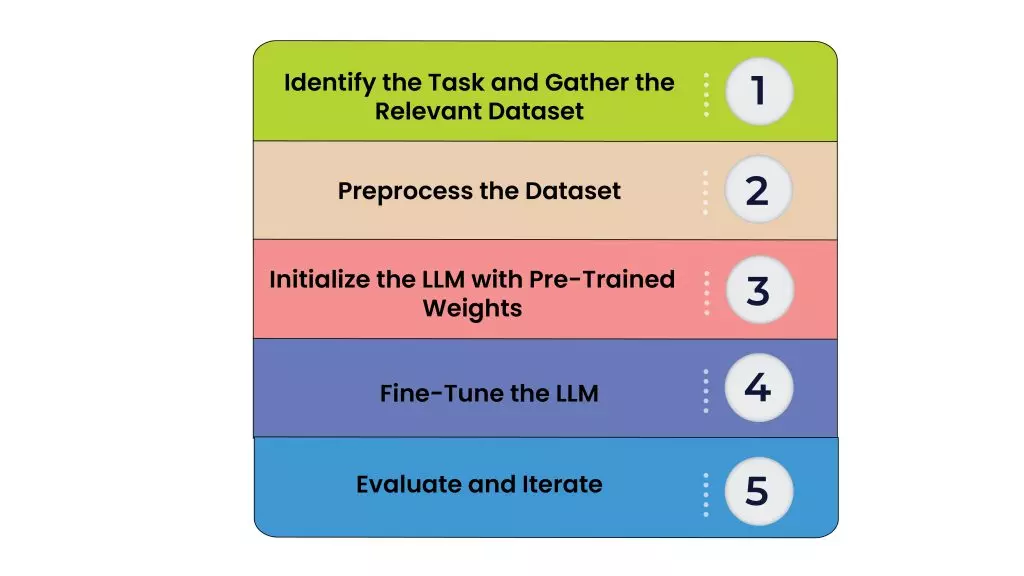

Generative AI fine-tuning 이란?

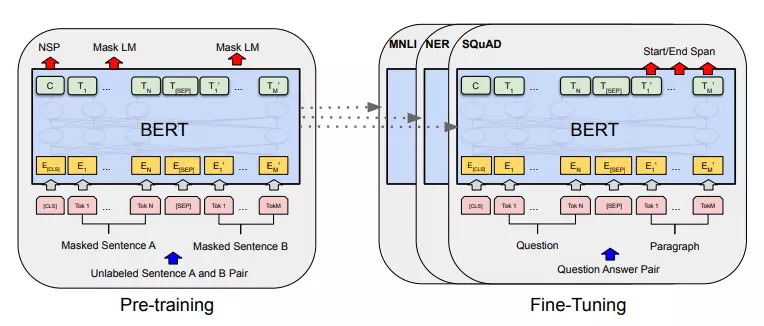

Fine-tuning이란, 특정 작업에 대한 범용 모델을 조정하기 위해 사전 훈련된 모델의 일부 매개변수를 레이블이 지정된 추가 데이터로 업데이트하는 것을 의미합니다. 이 기법을 사용하면 미세 조정된 모델이 사전 교육 프로세스에서 얻은 지식을 유지하면서, 사용자가 희망하는 전문 영역에 더 능숙해질 수 있습니다. 다만 한 영역에 과도하게 전문화되어 다른 작업의 수행 능력을 상실하는 과적합에 유의해야 할 필요가 있습니다.

fine tuning 방법

위의 그림을 토대로, fine-tuning의 방법을 요약하자면 다음과 같습니다.

- 작업을 식별하고 관련 데이터 집합 가져오기

- 데이터 세트 전처리

- 사전 학습된 가중치로 LLM 초기화

- 입력 계층 수정 및 모델 교육

- 평가 및 후기

이 과정에서 가장 핵심적인 것은 올바른 데이터를 선택하는 것입니다. 모델을 미세 조정할 때 데이터는 성능에 큰 영향을 미치기 때문입니다. 모델이 원래 학습된 데이터와 너무 유사한 데이터를 사용하면 큰 개선 효과를 볼 수 없을 것이고, 너무 다르면 새로운 작업에 잘 일반화하지 못할 수 있습니다.

따라서 데이터헌트는 모델이 수행하려는 작업과 관련된 데이터를 사용해 모델을 미세 조정합니다. 또한 사용하는 데이터에 오류가 없는지 철저히 검수해서 고품질의 데이터를 선별합니다. 가져온 데이터들은 모델이 실제 세계에서 접하게 될 데이터의 종류를 대표할 수 있어야 합니다.

위의 사진에서 설명하는 Pre-training (사전 학습) 이란, 기존에 임의의 값으로 초기화하던 모델의 가중치들을 다른 문제에 학습시킨 가중치들로 초기화하는 방법을 의미합니다. 예를 들어 감정 분석 문제를 학습하면서 얻은 언어에 대한 이해를 통해, 그 정보와 유사한 문제를 학습하는 데에 활용하는 것을 의미합니다. 반면 fine-tuning이란 사전 학습한 모든 가중치와 더불어 downstream task를 위한 최소한의 가중치를 추가해 모델을 추가 학습 및 미세 조정하는 방법입니다.

딥 러닝에서 사전 학습을 통해 효과적으로 hidden layer를 쌓으면 효율적인 훈련이 가능하다는 장점이 있습니다. 또한 사전 학습은 레이블 된 학습 데이터가 필요하지 않고 unsupervised learning (비지도 학습) 이 가능하기 때문에, 레이블이 없는 빅데이터를 가지고 훈련할 수 있습니다. 그러나 이것만으로 원하는 태스크를 수행하는 인공지능 엔진을 완성할 수 없기 때문에, 여기에 기반해 Fine tuning을 한 번 더 진행해야 합니다.

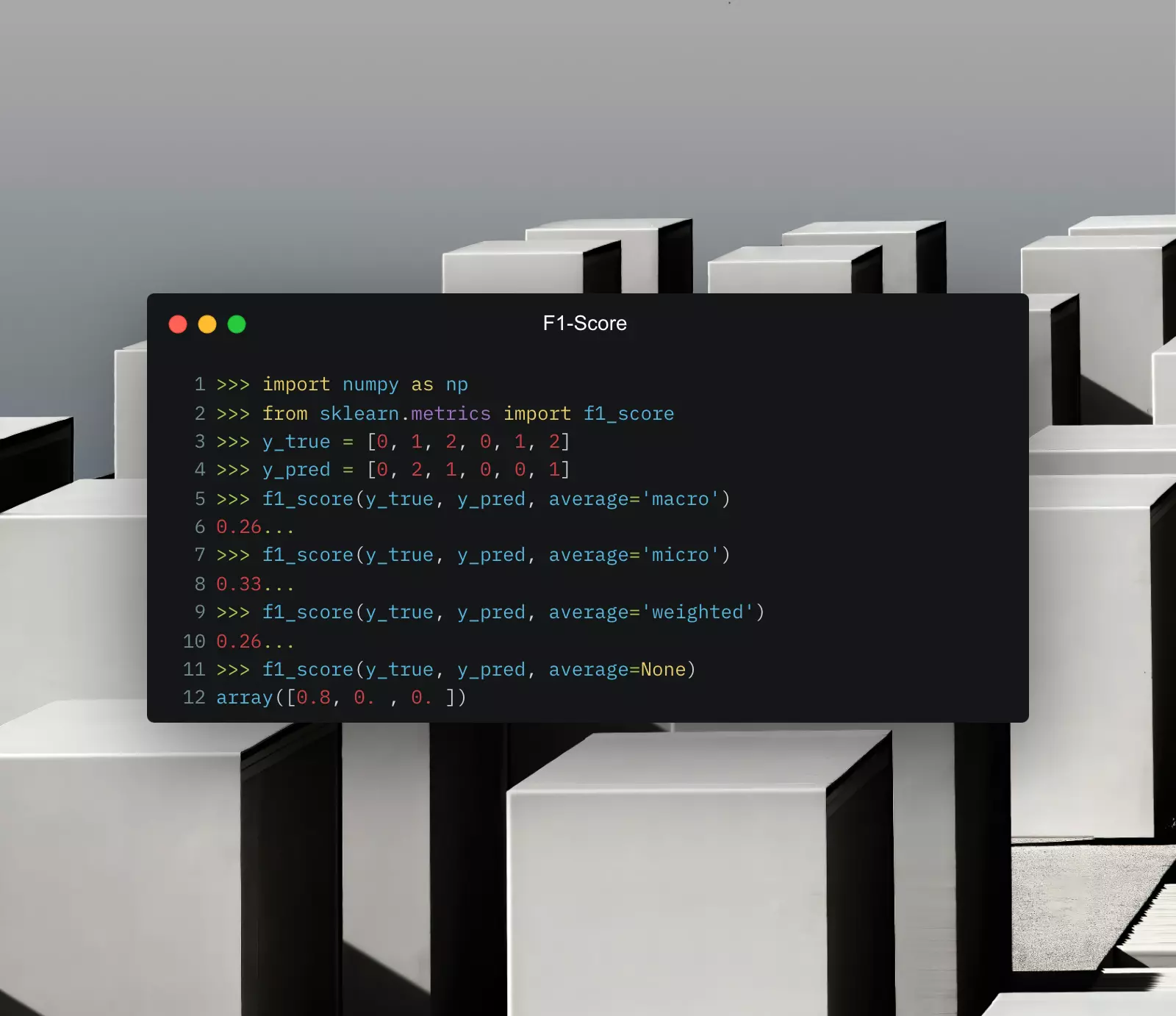

👉 AI모델의 성능을 평가하는 f1 score 알아보기

F1 Score 란 무엇인가?

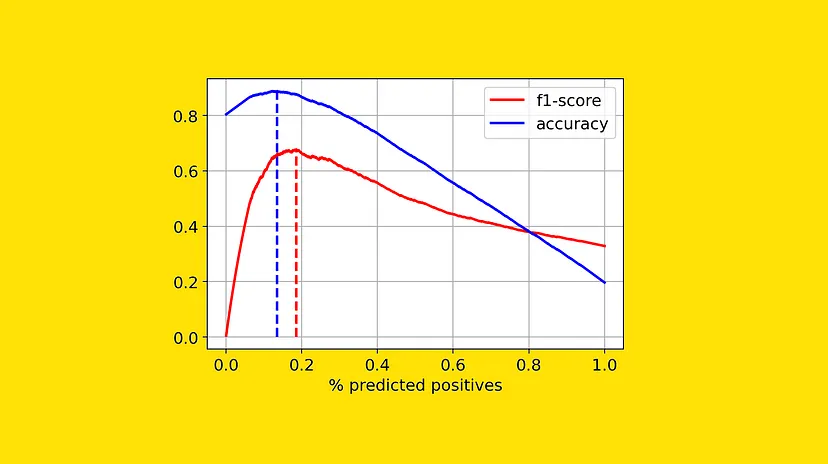

오랫동안 Model accuracy는 머신러닝 모델을 평가하고 비교하는 데 사용되는 유일한 지표였습니다. 그러나 Model accuracy는 모델이 전체 데이터 세트에서 몇 번이나 올바른 예측을 했는지를 계산하는 것으로, 평가한 횟수와 연관된 데이터가 전체 데이터 셋의 분포가 유사한 경우에만 정확하다고 말할 수 있다는 한계가 존재합니다.

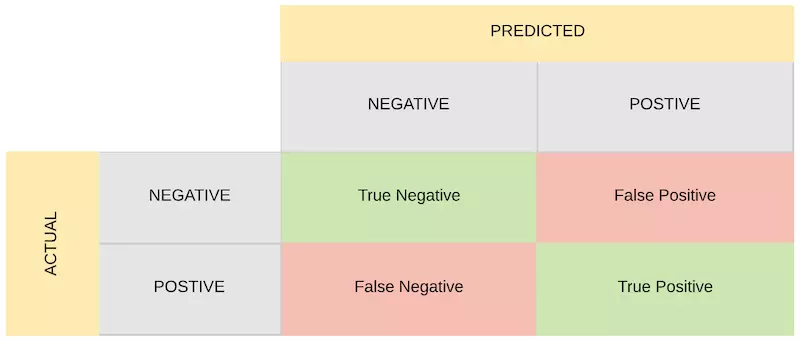

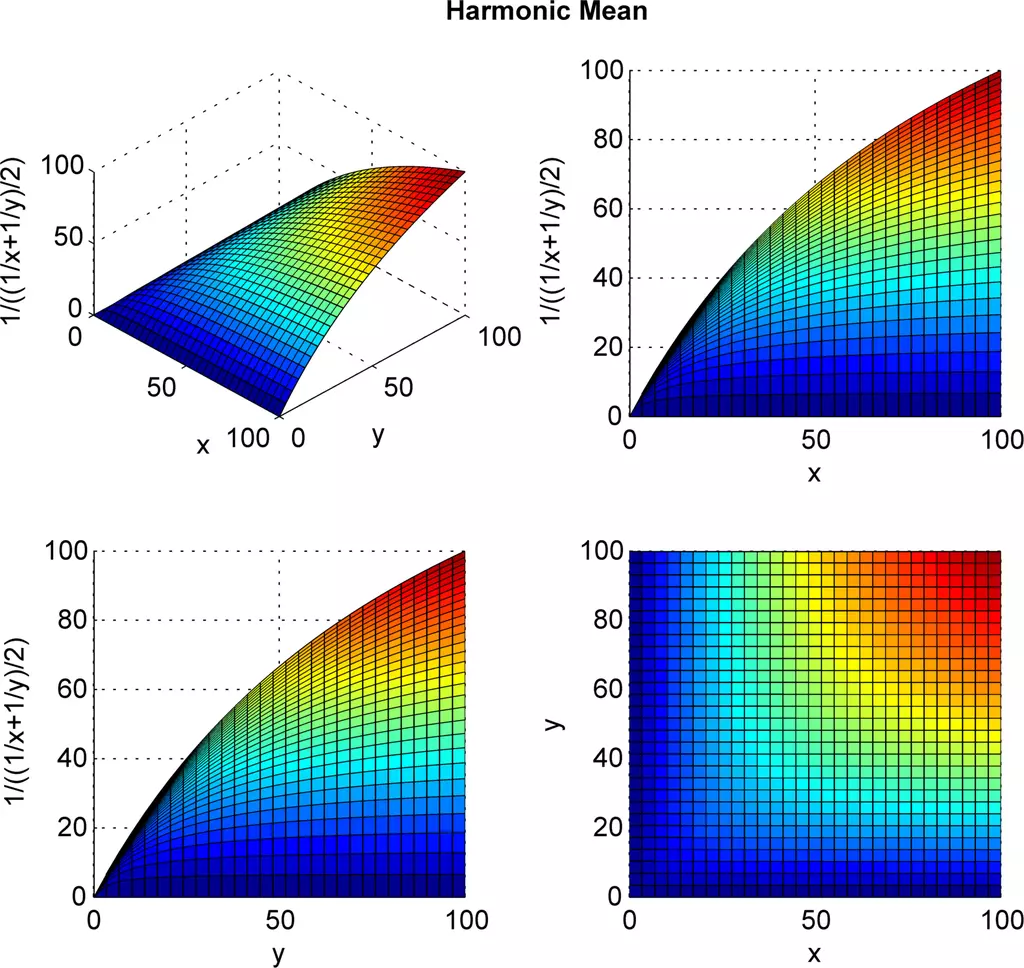

F1 score는 정밀도(Precision)와 재현율(Recall)의 조화평균으로 계산되는 성능 측정 지표입니다. 주로 이진 분류(classification) 문제에서 사용되며, 모델의 성능을 예측하고 결과를 평가하는 데 사용됩니다.

F1 score는 Accuracy처럼 전체 성능이 아닌 class 별 성능을 자세히 분석하여 AI 모델의 예측 능력을 평가하는 또 다른 머신 러닝 평가 지표입니다. F1 score는 모델의 Precision과 Recall, 두 가지 경쟁 meric을 결합한 것으로, 최근에는 널리 사용되고 있습니다.

이 글에서는 F1 Score의 구조와 원리, 사용 사례와 개선 방법에 대해서 소개하겠습니다.

F1 Score 원리와 계산법

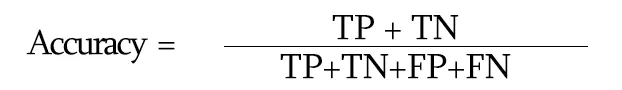

Accuracy

F1 Score에 대해 구체적으로 알아보기 전에, 먼저 Accuracy (정확도)에 대해 알아보겠습니다. classification 모델을 예를 들어 설명하면, Accuracy(정확도)는 모델이 전체 샘플 중에서 정확히 예측한 샘플의 비율을 나타내는 평가 지표입니다. 쉽게 말해, 모델이 얼마나 정확하게 예측하는지를 나타내는 값입니다.

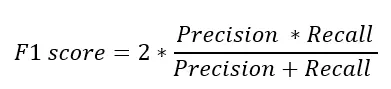

이 계산법들을 이해하기 위해서는 먼저 혼동 행렬을 살펴보고 가야 합니다. 혼동 행렬이란, 데이터 세트에 대한 모델의 예측 성능을 의미합니다. “양수” 클래스와 “음수” 클래스로 구성된 이진 클래스 데이터 집합의 경우, 혼동 행렬은 네 가지 필수 구성 요소를 가집니다.

- True Positive (TP) : “양성”으로 정확하게 예측된 샘플의 수

- False Positive (FP) : “양성”으로 잘못 예측된 샘플의 수

- True Negatives (TN) : “음성”으로 올바르게 예측된 샘플의 수

- False Negatives (FN) : “음성”으로 잘못 예측된 샘플의 수

Accuracy = (예측이 맞은 샘플의 수) / (전체 샘플의 수)

이를 간단한 예제로 설명해 보겠습니다. 예를 들어, 어떤 분류 모델이 100개의 샘플을 예측한 뒤, 85개의 샘플을 정확히 예측했다면, Accuracy는 85%가 됩니다. 하지만 Accuracy 계산 방식이 항상 적절한 것은 아닌데요. 그 이유는 ‘Imbalanced data’가 존재하기 때문입니다.

Imbalanced data

Imbalanced data(불균형 데이터)는 분류 문제에서 각 클래스의 샘플 수가 불균형한 상황을 의미합니다. 일반적으로는 하나의 클래스에 대한 샘플 수가 상대적으로 많고, 다른 클래스에 대한 샘플 수가 적어서 발생합니다.

예를 들어, Error detection을 위한 데이터셋은 일반적으로 정상 샘플은 많고, 비정상 샘플은 적습니다. 혹은 의료 진단에서 희귀 질병을 판단하는 경우에도 희귀 질병에 대한 샘플 수는 매우 적을 수 있습니다. 이러한 불균형 데이터는 모델의 성능을 평가하거나 학습할 때 문제를 야기할 수 있습니다. 이는 모델이 주로 많은 클래스에 집중하여 예측하고, 적은 클래스는 정확히 예측하지 못하는 결과를 초래할 수 있습니다. 적은 클래스에 대한 예측 정확도가 낮아지면 모델의 성능을 왜곡할 수 있기에 반드시 주의해야 하죠.

따라서 Accuracy, 정확도 계산 방식은 클래스가 불균형할 때는 좋은 metric이 아닙니다. 위에서 설명한 예시에 Accuracy를 평가 지표로 사용하면, 모델은 확률이 높은 클래스만 선택해서 정확도를 속이기도 합니다. 즉, 모델은 매우 나쁜 성능을 보이고 있지만 정확도는 높기 때문에 사용자 입장에서 좋은 결과처럼 보일 수 있기 때문에, Accuracy만으로 모델의 성능을 정확히 평가하기 어렵습니다. 따라서 데이터 불균형 문제를 해결하기 위해 F1 Score를 사용하게 됩니다.

F1 Score 원리

Precision (정밀도)와 Recall (재현율) 은 불균형 데이터에서 사용하는 가장 대표적인 metric이자, 지금 알아보려는 F1 Score의 기초라고 할 수 있습니다. 이 두 가지의 조화평균을 구한 것이 F1 Score이지만, 각각 개별 metric으로 사용하기도 합니다.

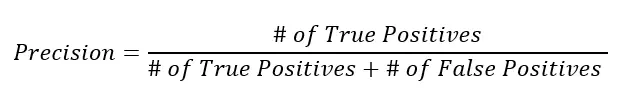

Precision

Precision(정밀도)는 분류 모델의 성능을 평가하기 위한 지표 중 하나로, 모델이 양성으로 예측한 샘플 중에서 실제로 양성인 샘플의 비율을 나타냅니다.

여기서 True Positive(참 양성,TP)는 모델이 양성으로 예측한 샘플 중에서 실제로 양성인 샘플의 수를 의미합니다. 반면 False Positive(거짓 양성, FP)로, 모델이 양성으로 잘못 예측한 샘플 중에서 실제로는 음성인 샘플의 수를 의미합니다.

간단한 예제로 설명해 보겠습니다. 만약 어떤 분류 모델이 100개의 양성이라고 예측한 샘플 중에서 85개가 실제로 양성이었고, 나머지 15개는 음성이었다면, TP는 85이고 FP는 15가 됩니다. 이 경우, Precision은 85 / (85 + 15) = 0.85가 됩니다. 정밀도는 "양성"으로 예측한 것 중에서 실제로 양성인 비율로, 모델이 얼마나 정확하게 양성으로 예측하는지를 나타내죠.

높은 정밀도는 모델이 거짓 양성을 최소화하고, 양성으로 예측한 것이 실제로 양성인 경우를 많이 찾아낼 수 있다는 것을 의미합니다. 따라서, 정밀도가 높을수록 모델의 성능이 좋다고 평가할 수 있습니다.

Recall

Recall(재현율)은 분류 모델의 성능을 평가하기 위한 지표 중 하나로, 실제로 양성인 샘플 중에서 모델이 양성으로 정확히 예측한 샘플의 비율을 나타냅니다.

여기서 TP는 모델이 양성으로 예측한 샘플 중에서 ‘실제로 양성인 샘플의 수’입니다. FN은 모델이 음성으로 잘못 예측한 샘플 중에서 실제로는 양성인 샘플의 수를 뜻합니다.

만약 어떤 분류 모델이 100개의 실제 양성 샘플 중에서 85개를 양성으로 정확히 예측했고, 나머지 15개를 음성으로 잘못 예측했다면, TP는 85이고 FN은 15가 됩니다. 이 경우, 재현율은 85 / (85 + 15) = 0.85가 됩니다.

재현율은 실제로 양성인 샘플 중에서 모델이 얼마나 많이 양성으로 예측하는지를 나타내므로, 모델이 양성인 샘플을 놓치는 정도를 나타냅니다. 높은 재현율은 모델이 실제로 양성인 샘플을 잘 찾아내는 것을 의미하므로, 모델의 민감도(Sensitivity)라고도 불립니다. 따라서, 재현율이 높을수록 모델의 성능이 좋다고 평가할 수 있습니다.

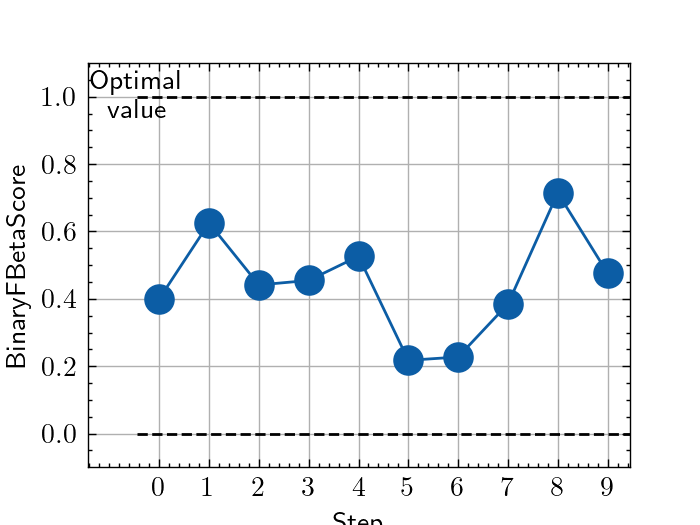

F1 score calculation

Precision은 모델이 분류한 양성 예측 중에서 실제로 양성인 비율을 나타내며, Recall은 실제 양성 중에서 모델이 양성으로 예측한 비율입니다. F1 score는 이 두 평가 지표를 모두 고려하여 모델의 예측 성능을 평가하기 때문에, 정확한 예측과 재현율의 평균을 동시에 고려할 수 있는 장점이 있습니다.

F1 Score는 이 두 가지의 지표의 조화평균을 구한 것인데요. 조화평균을 사용하는 이유는 두 metric 중 더 작은 값에 영향을 많이 받기 위함입니다. F1 Score는 0.0~1.0 사이의 값을 가지는데, Precision과 Recall 값이 모두 갖춰져야만 높은 지표를 얻을 수 있습니다. 불균형 데이터에 취약한 모습을 보였던 Accuray 보다 훨씬 더 모델 성능을 구체적으로 가늠할 수 있죠.

결론적으로, 다른 평가 지표들은 계산 방법이 간단한 대신 이진 분류 모델의 예측 성능을 전부 판별하진 못할 수 있어, 경향성이 생길 수 있습니다. 하지만, F1 score는 두 지표의 평균치를 구하는 조화 평균을 사용하여 조금 더 정확하게 모델의 예측 성능을 평가할 수 있습니다.

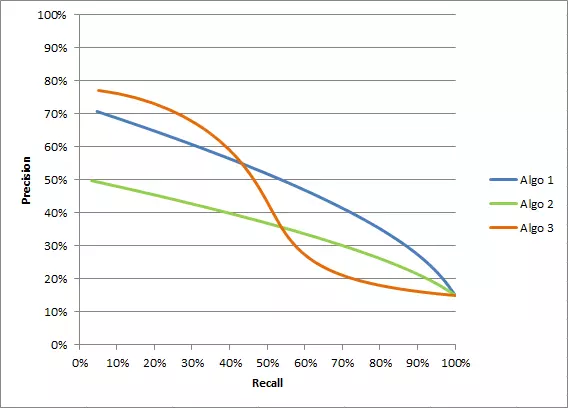

Precision vs. Recall

Recall(재현율)과 Precision(정밀도)은 분류 모델의 성능을 평가하는 지표로, 각각 모델의 예측 결과에 대한 다른 측면을 측정합니다. 두 metrics의 차이점은 다음과 같습니다.

정의

- Precision(정밀도): 모델이 양성으로 예측한 샘플 중에서 실제로 양성인 샘플의 비율

- Recall(재현율): 실제로 양성인 샘플 중에서 모델이 양성으로 정확히 예측한 샘플의 비율

관점

- 재현율은 실제 양성 중에 얼마나 많이 찾아내는지에 초점

- 정밀도는 모델이 양성으로 예측한 샘플 중에 실제로 양성인 비율에 초점

활용

- 재현율은 모델이 실제로 양성인 샘플을 얼마나 잘 찾아내는지를 나타내므로, 거짓 음성(실제 양성인데 음성으로 예측한 경우)를 최소화하는 데 중점

- 정밀도는 모델이 올바르게 양성이라고 분류한 샘플 중에 실제로 양성인 샘플이 얼마나 많은지를 나타내므로, 거짓 양성(실제로는 음성인데 양성으로 예측한 경우)를 최소화하는 데 중점

Precision-Recall Trade off

이상적으로 좋은 모델은 Positive 한 Positive 한 것을 제대로 분류하고, Positive 한 것만 제대로 분류하면 됩니다. 하지만 현실적으로 두 가지 모두 높이는 방법이 어렵기 때문에, 어떤 것에 초점을 맞출지를 고민할 필요가 있습니다.

두 가지 metric이 각각 중요하게 생각하는 것이 다르기 때문에, 활용 분야에서도 서로 다른 양상을 띱니다. 예를 들어, 암 진단 시에 실제 암 환자를 놓치지 않는 것이 중요한 경우 Recall에 중점을 두지만, 스팸 메일 분류 시 정상 메일을 스팸으로 잘못 분류하는 비율을 낮추기 위해 Precision에 초점을 맞추기도 하죠.

요약하면, 재현율은 실제 양성을 놓치지 않도록 하는데 초점을 둡니다. 반면 정밀도는 모델이 올바르게 양성으로 분류하는 비율에 초점을 둡니다. 둘은 분류 모델의 평가에서 상충하는 관계를 가지므로, 평가하고자 하는 문제나 목표에 따라 적절한 방법을 선택해야 합니다.

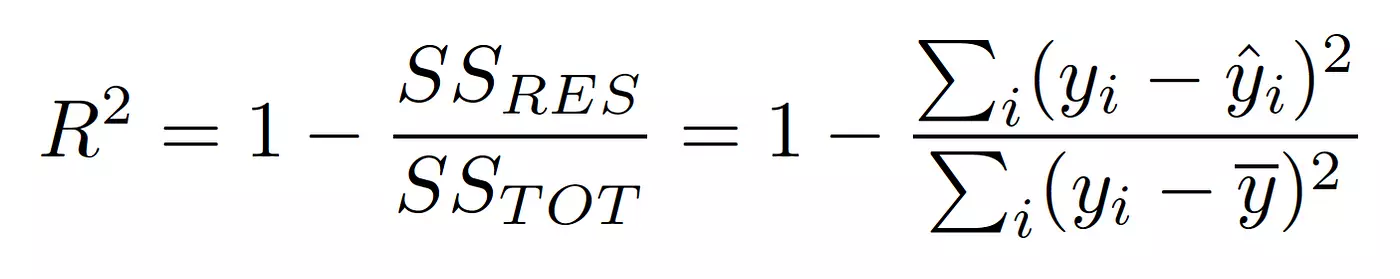

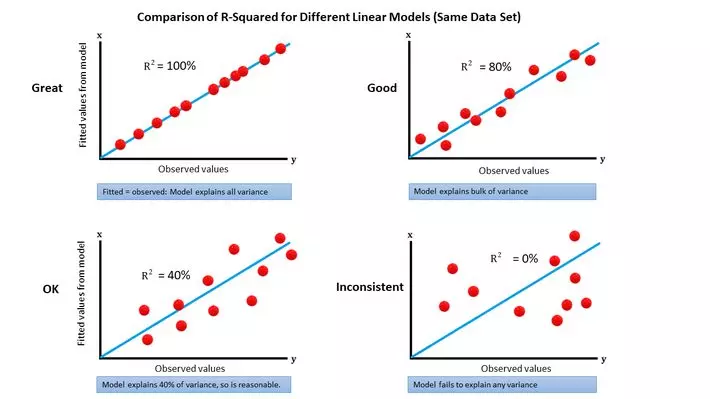

R-squared 란 무엇인가?

R-squared(결정 계수, coefficient of determination)은 회귀 모델에서 사용되는 평가 지표입니다. 모델이 주어진 데이터를 얼마나 잘 설명하는지를 측정하기 위해 사용됩니다. R-squared는 종속 변수의 총 변동량 중 모델이 설명하는 변동량의 비율로, 0부터 1까지의 값을 가집니다. R-squared 값이 1에 가까울수록 모델이 데이터를 잘 설명한다는 것을 의미합니다.

R-squared = 1 - (잔차 제곱합 / 종속 변수의 총 제곱합)

잔차 제곱합은 예측값과 실제 값 사이의 차이(잔차)를 제곱하여 모두 합한 값입니다. 종속 변수의 총 제곱합은 종속 변수 값들을 평균으로부터 얼마나 떨어진 정도로 제곱하여 모두 합한 값입니다. R-squared 값은 일반적으로 0부터 1 사이의 값을 가지지만, 음수 값이 나올 수도 있습니다.

이는 모델이 데이터를 잘 설명하지 못하는 경우를 의미합니다. R-squared는 모델의 적합도를 판단하는 데 사용되며, 높은 R-squared 값은 모델이 데이터를 잘 설명한다는 의미로 해석될 수 있죠. 하지만 R-squared는 독립 변수의 수와 관련이 없어서, 모델의 복잡성과 관련된 정보를 제공하지는 않습니다. 따라서, 모델 비교를 할 때에는 Accuracy와 마찬가지로 다른 평가 지표나 정보도 고려하는 것이 좋습니다.

F1 Score 사용 사례

F1 score는 F1 score는 정밀도(Precision)와 재현율(Recall)의 조화 평균값으로, 이진 분류 모델의 성능을 평가하는 지표 중 하나입니다. F1 score는 정밀도와 재현율의 균형을 조정하여 정확한 예측과 상승률의 평균을 동시에 고려할 수 있는 장점이 있습니다.

- 클래스 불균형 데이터:

클래스가 불균형하게 분포된 경우, 즉 한 클래스의 샘플 수가 다른 클래스에 비해 현저히 많은 경우, Accuracy(정확도)만으로 모델을 평가하는 것은 적절하지 않을 수 있습니다. 이런 경우 F1 score를 사용하여 모델의 성능을 정확하게 측정할 수 있습니다. - 암 진단 등 실제 양성의 중요성:

실제로 양성인 샘플을 놓치면 큰 문제가 발생하는 경우, 예를 들어 암 진단 등에서 중요한 참 양성을 잘 판단하는 능력을 가진 모델이 필요한 경우가 있습니다. 이때 F1 score는 모델의 재현율과 정밀도 둘 모두를 고려하여 성능을 평가할 수 있는 지표입니다. - 텍스트 분류나 정보 검색:

NTT 인식이나 단어 분할의 평가 등 NLP 프로세스에서도 사용됩니다. 텍스트 분류 문제나 정보 검색에서는 긍정과 부정, 또는 관련 있는 문서와 관련 없는 문서 등과 같이 두 개의 클래스로 분류하는 경우가 많습니다. 이런 문제에서도 F1 score를 사용하여 정밀도와 재현율을 고려한 성능 평가를 할 수 있습니다.

F1 Score 개선하는 방법

F1 Score는 0~1까지 점수를 매길 수 있습니다. F1 Score가 낮게 나온다면 정밀도와 회수율이 모두 낮다는 뜻으로 해석할 수 있습니다. F1 Score를 구성하는 정밀도와 재현율이 각각 낮은 경우가 있습니다. 정밀도 점수가 낮으면 머신러닝 모델이 잘못된 주석을 생성하고 있다는 뜻이며, 재현율이 낮다는 것은 머신러닝 모델이 생성했어야 하는 주석을 생성하지 못했음을 나타냅니다. 이는 유형 시스템의 복잡성이나 교육 문서의 적절성, 인간 라벨러의 기술 및 기타 요인 등 다양한 요인에 따라 발생할 수 있습니다. 아래는 F1 Score를 개선하는 일반적인 방법입니다.

- 학습 데이터 조정:

학습 데이터 자체를 더 추가하거나 데이터에 주석을 더 추가하는 것입니다. 그 외에도 데이터 가공 품질을 개선하는 방식으로, F1 Score를 개선할 수 있습니다. - 샘플링(Balancing Sampling):

클래스 불균형 데이터에서는 일반적으로 예측하고자 하는 클래스보다 다른 클래스의 샘플 수가 많을 수 있습니다. 이러한 경우, 데이터를 균형있게 샘플링하여 모델을 학습시키는 것이 중요합니다. Undersampling(언더샘플링)은 다수 클래스의 샘플 수를 일부 감소시키는 방법이고, Oversampling(오버샘플링)은 소수 클래스의 샘플 수를 증가시키는 방법입니다. - 가중치 부여(Class Weights):

소수 클래스의 중요성을 강조하기 위해, 소수 클래스에 더 큰 가중치를 부여하여 모델의 학습에 반영할 수 있습니다. 이렇게 하면 모델이 소수 클래스를 더 잘 학습할 수 있으며, 예측 성능을 향상시킬 수 있습니다. - 예측 임계값 조정(Threshold Adjustment):

모델의 예측 임계값을 조정하여 정밀도와 재현율 사이의 균형을 조정할 수 있습니다. 예를 들어, 임계값을 낮추면 분류 결과가 더 많이 양성으로 분류되어 재현율이 증가하고, 정밀도가 감소할 수 있습니다. 임계값을 높이면 정밀도가 증가하고, 재현율이 감소할 수 있습니다.

일반적으로 혼동되는 유형이나 자주 발생하는 유형을 낮은 확률로 식별하게끔 만들면 소수 클래스에 대한 인식 능력이 올라갈 것입니다. 이외에도 특정 유형의 F1 Score가 낮은 경우, 해당 유형에 적용되는 주석 지침의 명확성을 검토해야 합니다. 교육 데이터에서 자주 발생하지 않는 유형에 대해 사전을 추가하는 등 학습 데이터를 자세히 검토하고 모니터링하는 방법으로 F1 Score를 높일 수 있습니다.

F1 Score 한계와 대안

한계

이렇듯 F1 Score는 이진 분류 모델을 평가하기 위해 범용적으로 사용하는 metric이지만, 완벽한 것은 아닙니다.

- F1 Score는 오차 분포에 대한 정보를 제공하지 않습니다.

F1 Score는 Precision과 Recall을 가지고 모델의 성능을 요약하는 단일값을 제공합니다. 그러나 특정 응용프로그램에서 중요할 수 있는 오류 분포에 대한 정보는 제공하지 않습니다. - F1 Score는 Precision과 Recall의 동등한 중요성을 가정합니다.

Precision과 Recall 모두에 동등한 가중치를 부여하며, 동일한 중요성을 가지고 있다고 가정합니다. 그러나 두 지표는 일부 애플리케이션에서 중요성이 다를 수 있기 때문에, 조화평균을 구하는 F1 Score보다 다른 지표가 더 유용할 수 있습니다. - F1 Score는 다중 클래스 분류에 최적화되어 있지 않습니다.

이 지표는 이진 분류 모델을 위해 설계되었기 때문에, 다중 클래스 분류 문제에는 적용되지 않을 수 있습니다. 이 경우에는 Precision이나 Micro/Macro F1 Score와 같은 지표가 더 적절할 수 있죠. - F1 Score는 데이터의 특정 패턴에 민감하지 않을 수 있습니다.

F1 Score는 데이터의 특정 패턴이나 특성을 고려하지 않는 범용적인 metric입니다. 경우에 따라, 문제의 특정 속성을 캡쳐하고자 한다면 보다 전문화된 metric이 필요할 수 있습니다.

그렇다면 대안은?

결론적으로, F1 score는 클래스 불균형 문제에서 유용하고 재현율과 정밀도의 균형을 평가하는 좋은 평가 지표입니다. 하지만 위의 한계들을 고려하여 모델의 성능 평가를 보다 포괄적으로 진행하는 것이 좋습니다. 다른 평가 지표와 함께 사용하거나, 문제의 특성에 맞게 적절한 지표를 선택하는 것이 중요합니다. 아래는 F1 Score를 보완할 수 있는 대안을 소개합니다.

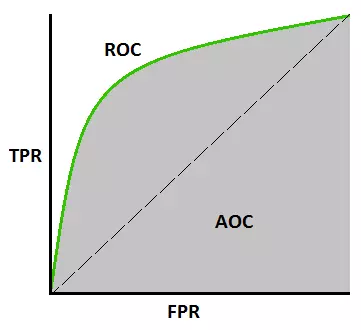

ROC Curves, AUC

ROC(Receiver Operating Characteristic) 곡선 및 AUC(Area Under the Curve)는 이진 분류 모델의 성능을 평가하는 데 사용되는 평가 지표입니다. 다양한 분류 임계값 범위에서 양의 인스턴스와 음의 인스턴스를 구별하는 모델의 능력을 측정할 수 있습니다. 특히 F1 Score와 마찬가지로 imbalanced data에 유용하다는 특징이 있습니다. 자세한 내용은 아래에서 확인하실 수 있습니다.

ROC curves

- 이진 분류 모델에서 임계값을 변화시켰을 때, 모델의 Precision(True positive Rate)과 1에서 모델의 특이도(False Positive Rate)를 각각 x축과 y축으로 그린 곡선

- 모델이 양성과 음성을 얼마나 잘 분류하는지 시각화할 수 있음

- ROC Curves 상에서 왼쪽 위 모서리에 가까운 지점에 위치할 수록 좋은 성능을 나타냄

AUC

- ROC 곡선 아래의 면적으로, ROC 곡선의 모든 지점에서의 재현율과 특이도의 조합에 대한 면적을 의미

- AUC 값은 0부터 1까지의 범위를 가지며, 최적의 모델에서는 AUC가 1에 가까운 값이 됨

- AUC는 임의로 선택된 양성 샘플과 음성 샘플을 비교했을 때, 양성 샘플이 더 높은 확률로 예측되는 경향을 제공

- AUC 값으로 모델을 비교하면, AUC가 더 큰 모델일수록 더 좋은 성능을 가지는 경향

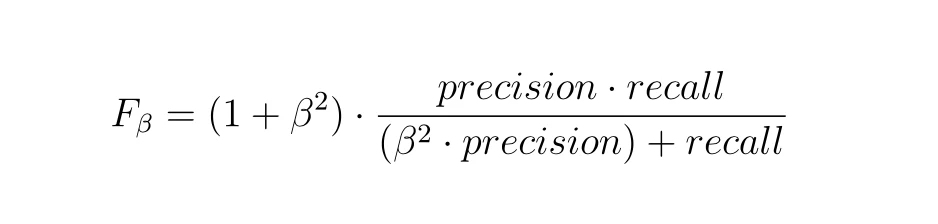

F-Beta Score

F-beta score도 F1 Score와 마찬가지로 이진 분류 모델의 성능을 평가하는 지표로, Precision과 Recall의 조화 평균을 계산해서 최종 점수를 매기는 방식입니다. 다만 계산 방식에서 F1 Score와는 조금 다른 것을 확인할 수 있습니다.

F-beta score = (1 + beta^2) * (Precision * Recall) / ((beta^2 * Precision) + Recall)

여기서 beta는 모델이 재현율에 대해 정밀도를 얼마나 중요하게 간주하는지를 제어하는 매개 변수입니다. beta 값이 클수록 재현율에 더 큰 가중치를 두게 되고, 작을수록 정밀도에 더 큰 가중치를 두게 됩니다. 일반적으로 beta 값은 1, 0.5, 2와 같이 정해지며, beta 값이 1인 경우에는 F1 score와 동일합니다.

F-beta score는 정밀도와 재현율 사이의 균형을 조정하여 모델의 예측 성능을 평가하는 데 사용됩니다. 예를 들어, 실제 양성을 제대로 찾아내는 재현율이 더 중요한 경우에는 beta 값을 2로 설정하여 재현율에 더 큰 가중치를 둘 수 있습니다. 반대로, 정밀도가 더 중요한 경우에는 beta 값을 0.5로 설정하여 정밀도에 더 큰 가중치를 둘 수 있습니다.

따라서 F-beta score를 사용하면 모델의 예측 성능을 정밀도와 재현율의 균형을 조정하여 관리할 수 있습니다. 모델의 특성과 평가하고자 하는 문제에 따라 적절한 beta 값을 선택하여 F-beta score를 계산할 수 있는 것이죠.

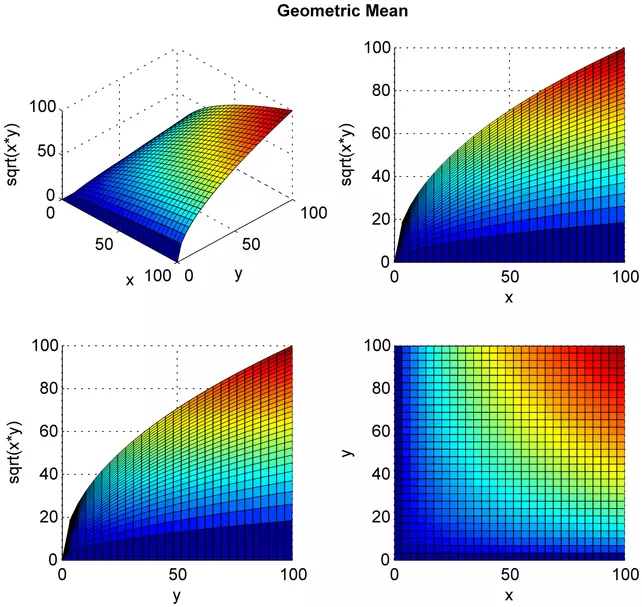

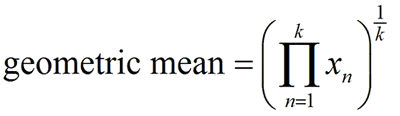

Geometric Mean

G-mean(Geometric Mean)은 이진 분류 모델의 성능을 평가하기 위한 평가 지표 중 하나입니다. 재현율(Recall)과 특이도(Specificity)의 기하 평균으로 계산되며, 클래스 불균형 문제에서 모델의 성능을 정확하게 평가할 수 있도록 도와줍니다.

G-mean = √(Recall * Specificity)

Recall은 실제 양성 중에서 모델이 양성으로 정확히 예측한 비율이며, 특이도는 실제 음성 중에서 모델이 음성으로 정확히 예측한 비율입니다. G-mean은 이 두 지표를 기하 평균한 값으로, 모델의 양성 및 음성 클래스에 대한 평균 예측 성능을 나타냅니다.

G-mean은 클래스 불균형 데이터에서 모델의 성능을 평가하는 데 유용합니다. 이는 불균형 데이터에서 일반적인 평가 지표인 정확도(Accuracy)가 왜곡될 수 있는 경우를 보완하고, 모델이 양성 및 음성 클래스를 모두 골고루 잘 예측하는 성능을 측정할 수 있도록 도와줍니다.

따라서 G-mean은 모델의 예측 능력과 신뢰성을 동시에 평가할 수 있는 지표로서 활용됩니다. 값이 1에 가까울수록 모델의 성능이 높다고 해석할 수 있습니다. 그러나 G-mean도 특정 문제와 데이터에 따라 한계가 있을 수 있으므로, 다른 평가 지표와 함께 고려하고 문제의 특성에 맞는 지표를 선택하여 사용하는 것이 중요합니다.

결론: 학습 데이터 정확도를 통해 F1 Score를 개선하고, 모델 완성도를 확보할 수 있다.

F1 Score는 Precision과 Recall 모두에 동일한 가중치를 할당하기 때문에, 분류 모델 평가 지표에서 중요한 차이점이 가려질 수 있습니다. F1 Score를 사용할 때는 구체적인 문제와 맥락을 고려하면서, 과제의 목표와 요구사항을 탐색하고 적절한 측정 기준을 선택할 필요가 있습니다. 즉, 구체적인 상황과 맥락을 고려했을 때 다른 평가지표가 F1 Score보다 더 효과적일 수 있다는 것이죠. 모델의 성능을 종합적으로 평가하기 위해서는 다른 메트릭 및 요인을 함께 평가할 필요가 있습니다.

상황에 따라 다르지만 F1 Score가 0.7 이상일 때 좋은 모델이라고 간주하고 있습니다. 높은 점수를 가진다고 해서 만능인 모델은 아니지만, F1 Score가 높은 모델은 분명 종합적으로 모델 성능이 좋다고 볼 수 있죠. 높은 F1 Score를 확보하기 위해서는 사전에 학습한 데이터의 품질이 중요하며, 성능 개선을 위해 훈련 데이터를 구체적으로 검토하고 모니터링하는 과정이 중요합니다. 데이터헌트가 학습 데이터 정확도 99% 달성까지 많은 연구와 노력을 거듭한 이유도, 최종적인 모델의 완성도를 높이기 위함인 것이죠.

Prompt engineering 이란?

Prompt engineering은 GPT-3에서 등장한 방법론입니다. 고정 모델이 상황 내의 학습에 의해 다양한 작업을 수행하도록 조건을 지정하는 방식으로 진행합니다. Zero-shot, few-shot 등의 텍스트 프롬프트를 직접 작성하여 특정 작업에 대한 모델을 조정합니다. 수동 작업이 많이 필요하다는 단점이 있으며, fine tuning에 비해 다소 성능이 떨어진다는 단점이 있습니다.

유사한 개념으로 Prompt-tuning 및 Optimization 방법론이 있습니다. 프롬프트를 조정 가능한 매개변수로 처리하여 LLM 성능을 최적화하는 방식입니다. Fine tuning보다 리소스를 절약할 수 있으며, Prompt engineering보다는 높은 품질의 출력을 제공하죠. 또한 프롬프트 제작에 필요한 수동 작업의 필요성을 축소할 수 있다는 장점이 있습니다.

실제 사례

Stable diffusion Model의 인기가 많아짐에 따라, 이 모델을 파인튜닝하는 Dreambooth도 함께 주목받고 있습니다. Dreambooth는 구글 연구진이 발표한 논문에서 사용한 학습 방법의 이름으로, Imagen이라는 text-to-image 생성 모델을 어떤 subject에 대한 몇 장의 사진으로 Fine-tuning 하여 개인화된 text-to-image generative ai를 만들고, 해당 subject를 새로운 context에서 높은 fidelity로 이미지를 생성할 수 있게 해주는 학습 방법입니다.

Dreambooth를 사용하면 몇 장의 사진만으로 주제의 시각적 특징에 대한 높은 충실도를 유지하면서, 새로운 맥락의 사진을 합성할 수 있습니다. 또한 몇 장의 이미지만을 가지고 text-to-image diffusion 모을 fine-tuning 하면서도, 기존 모델의 Semantic Knowledge를 유지할 수 있다는 장점이 있습니다.

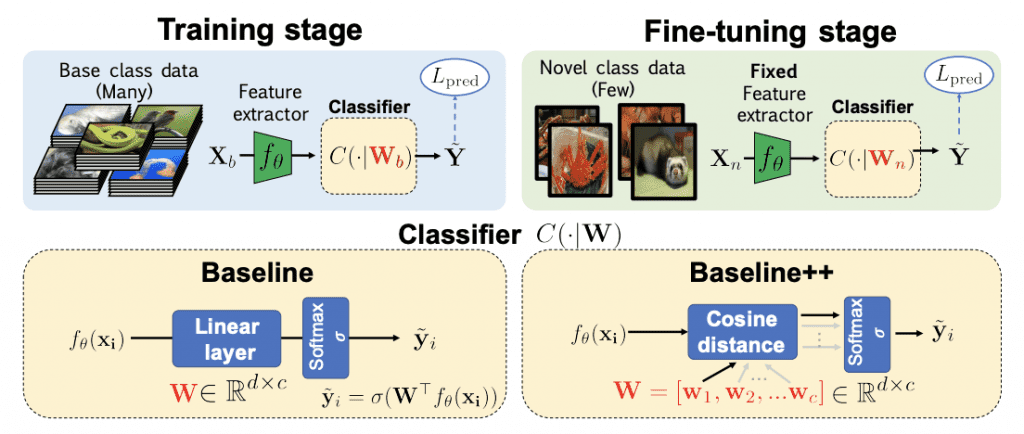

fine tuning에서 Data quality

Few shot learning은 모델이 주어진 문제를 해결하는 방법을 학습하는 것입니다. 이 접근 방식에서 모델은 매우 제한된 수의 샷을 제공받고, 이 정보를 사용하여 해당 작업에 적응하고 수행하는 것을 목표로 합니다. 이는 기존 지도 학습에서 사용할 수 있는 데이터가 충분하지 않을 때 유용한 방법론이었습니다. 대규모 언어 모델에서 새 작업과 관련된 작은 데이터 세트로 fine tuning을 하는 것이 few-shot learning의 주요 용도이기도 하죠.

일부 다른 점도 있지만 Fine tuning 작업 자체는 few shot learning과 유사한 점이 있다는 것을 알 수 있습니다. 따라서, 두 작업 모두 성공적으로 수행하기 위해서는 데이터가 중요하다는 것을 알 수 있습니다. 적당한 양이든, 소량의 양이든 고품질의 데이터를 통해 학습해야만 모델의 학습이 잘 이루어지고 적합한 결과를 도출할 수 있기 때문입니다.

Generative AI의 fine tuning은 방대한 데이터가 필요한 일인 만큼 개인이 python 등의 도구를 사용해 진행하기 어려울 수 있습니다. 아래는 AI fine tuning에 도움이 될 기업 리스트입니다.

결론: Generative AI에 대한 관심은 지속적으로 이어질 것이므로, 어떤 방식으로 적용하고 활용할 것인지에 대해 고민해야 합니다.

현재 전문가들은 AI가 고객 서비스의 게임 체인저라고 설명합니다. 기업이 고객 서비스와 관련해 직면한 오랜 과제를 해결할 수 있는 열쇠이기 때문이죠. 많은 기업들은 AI를 통해 숙련된 노동력 부족과 의사결정 속도, 규모에 따른 대량 개인화 등의 문제를 극복할 수 있게 되었습니다.

배리 쿠퍼(Barry Cooper) NICE CX 사업부 사장은 최근 포브스 기고문을 통해 제너레이티브 AI가 모든 산업과 조직의 성장 궤도에 빠르게 얽히면서 가까운 미래에 사람들이 기술과 상호작용하는 방식을 변화시킬 것이라고 전망했습니다. 하지만 기술이 아무리 빠르게 발전하더라도, 산업적 특징에 맞는 Generative AI를 채택하지 못한다면 성공으로 이어지기는 어렵습니다.

데이터헌트는 고객사의 비즈니스를 분석하여 AI를 활용할 수 있는 방향성을 적극적으로 파악하고 AI 서비스를 구축하고자 노력하고 있습니다. 경쟁이 치열한 비즈니스 환경에서 입증된 실적이 있는 숙련된 회사와 연결되면 AI를 도입하고 사용하는 과정에서 경쟁에서 우위를 점할 수 있습니다.

고도화된 Generative AI의 시작은 고품질 데이터의 분포에서 시작되므로, 학습 모델 데이터부터 세심하게 고려해야 합니다. 이제 기업은 Generative AI를 빠르게 활용할 수 있도록 필요한 기술 전문성과 데이터 아키텍처, 운영 모델 등에 대한 식견이 넓은 전문가와 함께할 필요가 있습니다.

'say와 AI 챗봇친구 만들기 보고서' 카테고리의 다른 글

| [스타트업 미국진출 가이드] ChatGPT의 등장에 따른 법적 리스크 - 인포유앤컴퍼니, 두산 디지털이노베이션과의 AI Chat 프로젝트 성료 (2) | 2023.10.17 |

|---|---|

| 챗GPT가 만든 다큐, 시사기획창 [AI혁명-챗GPT에 AI를 묻다] (1) | 2023.10.16 |

| AI의 역사 (0) | 2023.10.15 |

| Generative AI (생성 AI) 란? [개념, fine tuning, 활용] (0) | 2023.10.15 |

| 생성형 AI 챗봇 GPT 실패의 원인과 해결방안 분석 (0) | 2023.10.15 |