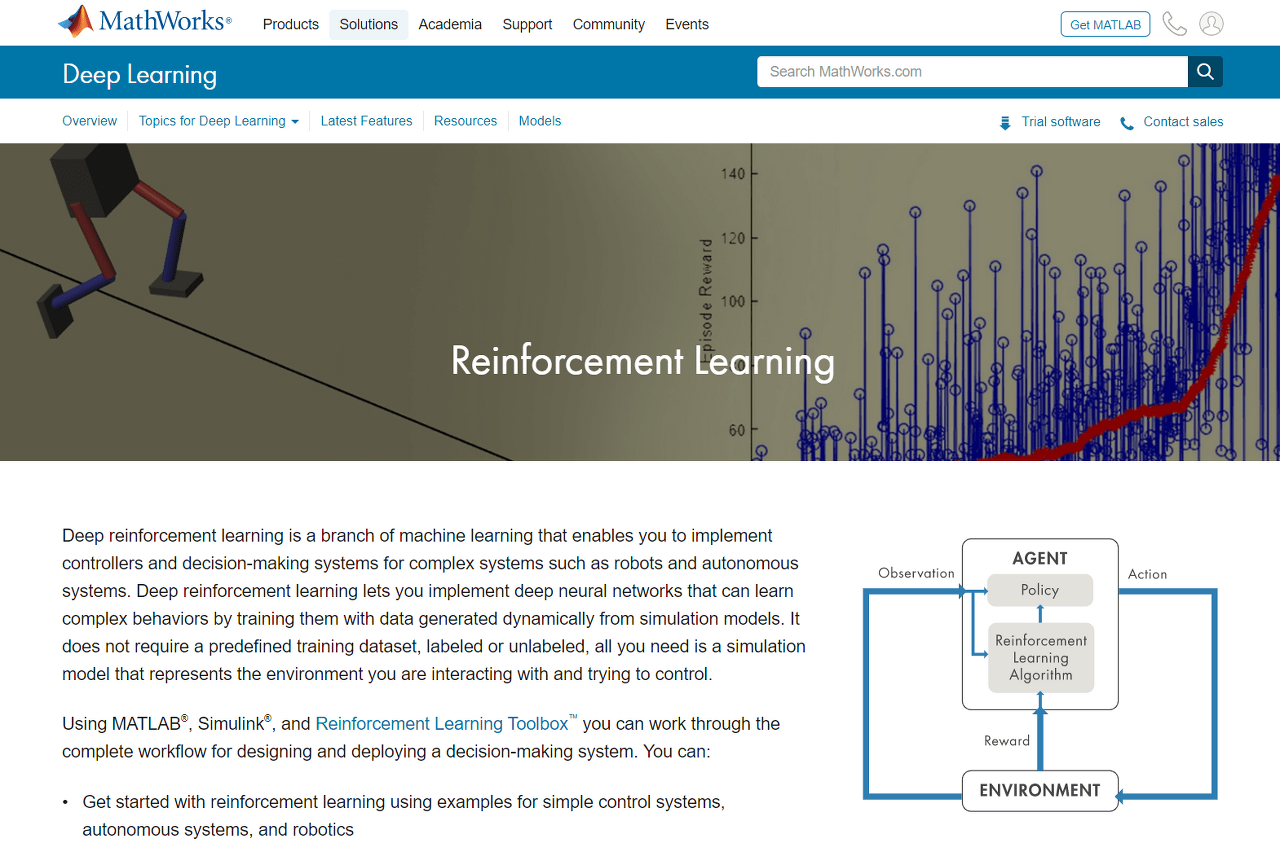

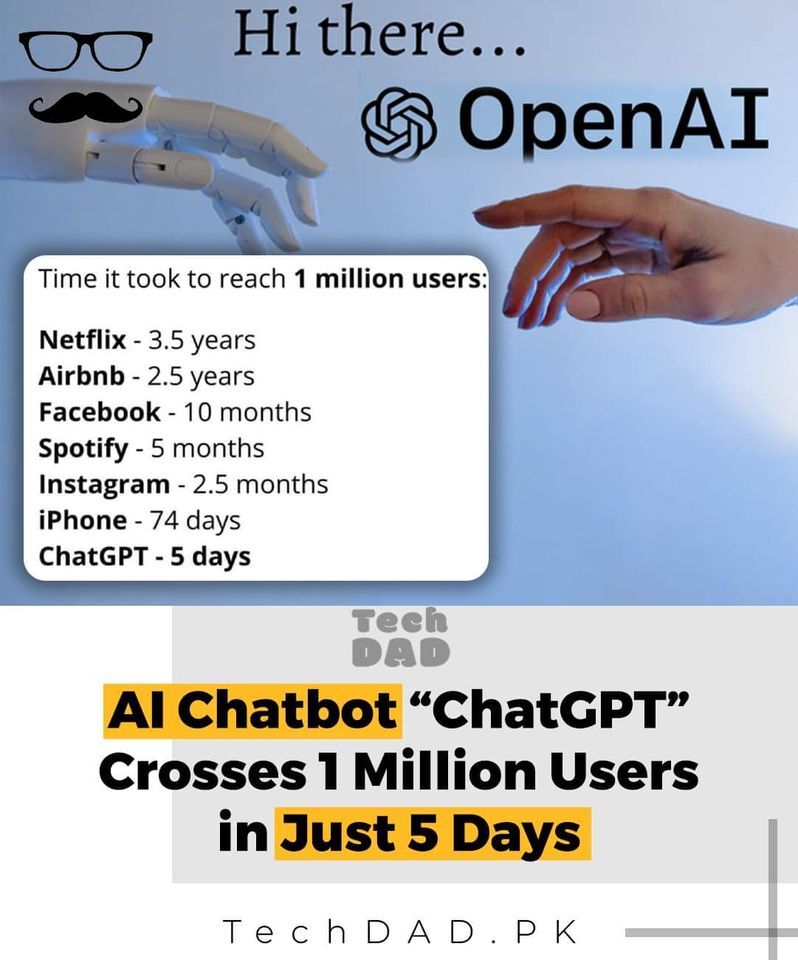

ChatGPT, 출시 5일만에 100만명이 사용한 AI 챗봇

ChatGPT의 정의 및 예시, 장점과 단점, 기술적 특징과 앞으로의 미래에 대해 함께 알아봅니다.

ChatGPT가 대단한 이유?

Netflix – 3.5 년

Facebook – 10 개월

Spotify – 5 개월

Instagram – 2.5 개월

ChatGPT – 5일

위에 언급한 기간은 주요 서비스별로 100만명의 사용자를 달성하기까지 걸린 시간입니다. 11월 30일 OpenAI에서 개발한 인공지능 챗봇 ChatGPT의 인기가 출시 5일만에 100만명의 사용자를 달성할 정도로 화제입니다. 100만명의 사용자를 달성하기 위해 다른 서비스가 걸렸던 기간을 비교해보면 전세계적인 인기를 실감해볼 수 있습니다. 과연 어떤 서비스이길래 이렇게 많은 사람들이 열광하는 걸까요? ChatGPT이 무엇인지, 어떻게 활용할 수 있을지 함께 알아봅니다.

출처 : techdad.pk

ChatGPT의 정의 및 예시

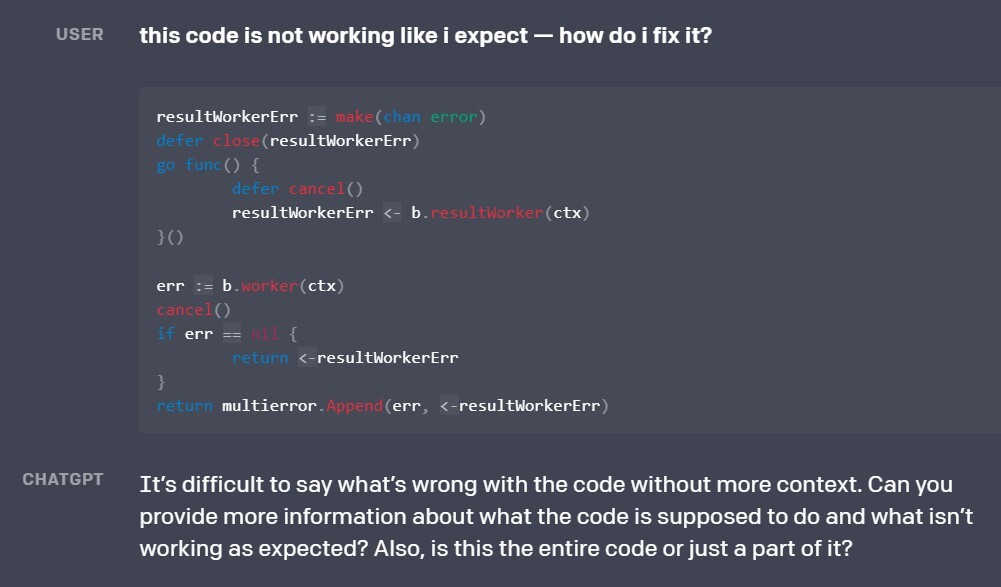

ChatGPT는 OpenAI 에서 개발한 대화 전문 인공지능 챗봇입니다. 대화창을 통해 사용자가 텍스트를 입력하면, 그에 맞추어 대화를 함께 나누는 서비스입니다. ChatGPT와 대화 할 수 있는 예시를 한번 볼까요?

“간단한 용어로 양자 컴퓨팅 설명”

“10살 생일을 위한 창의적인 아이디어가 있나요?”

“Javascript에서 HTTP 요청을 하려면 어떻게 해야 하나요?”

지식 정보 전달 뿐만 아니라, 창의적인 아이디어에 대한 요청 및 코딩에 대한 기술적 문제 해결까지 굉장히 광범위한 범위를 다루고 있습니다. 또한 사용자가 대화 초반에 말한 내용을 기억하고, 후속 수정을 제공할 수 있으며 부적절한 요청을 거절하도록 훈련 되어 있죠.

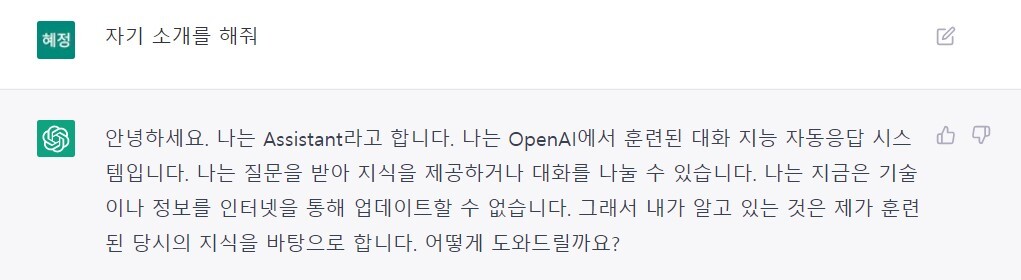

ChatGPT에 자기 소개를 해보라고 물어보았더니 다음과 같이 답변을 하네요.

chatGPT 예시

이야기 할 수 있는 내용에 대한 한계를 스스로 언급하는 것도 흥미롭게 느껴졌습니다. ChatGPT는 학습된 데이터를 기반으로 대화를 하기 때문에 인공지능에서 문제로 지적되는 정보가 편향될 가능성이 있습니다. 즉, 잘못된 정보 및 유해한 지침이나 편향된 콘텐츠를 생성할 수 있는 가능성을 물론, 2021년 이후 세계 및 사건에 대해서는 제한적일 수 밖에 없는 한계를 갖고 있죠.

ChatGPT는 한글 사용이 자연스럽게 가능합니다. 같은 질문이라도 영어로 물어보면 영어로 되어있는 데이터가 많기 때문에 더 상세하게 대답을 하는 경우가 많습니다.

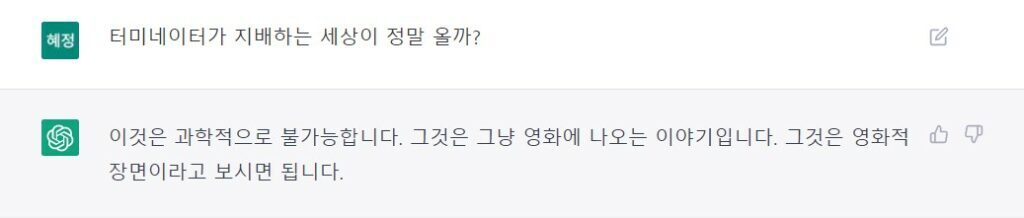

chatGPT 예시

chatGPT 예시

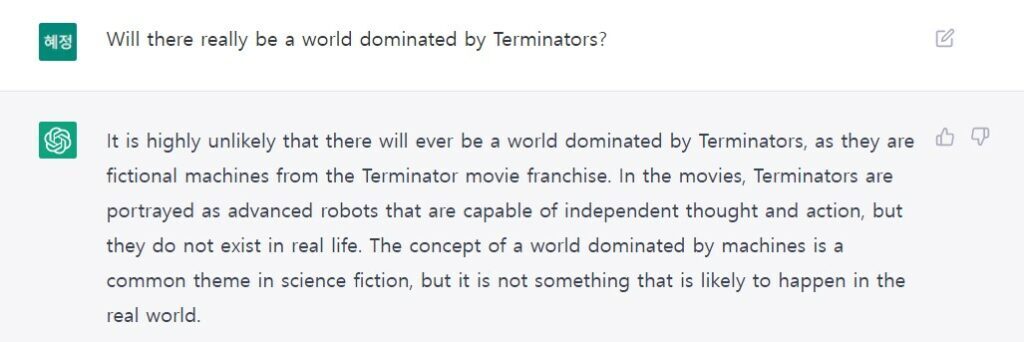

ChatGPT가 GPT 3.5를 기반한 기술을 사용하면서 농담이 섞인 대화도 가능하게 되었습니다. 사실에 의거한 지식 정보가 아니라 상상력이 동반되는 이야기를 함께 나눌 수 있는 점이 신기하고 재미있었어요. 퀸의 We will rock you 노래 가사를 인공지능 개발자 버전으로 바꿔 달라는 저의 부탁에 ChatGPT가 재미있게 개사를 했습니다.

chatGPT 예시

ChatGPT의 장점 – 구글과 파이썬을 능가할 수 있는 이유?

ChatGPT가 구글을 대체하거나 능가할 수 있다고 사람들이 말하는 이유는 무엇일까요? 사용자가 입력한 질문에 답변을 해주는 수준이 사전적 답변을 넘어서, ‘호랑이와 토끼가 나오는 소설을 써줘’, ‘연봉 10억원이 넘으려면 어떤 노력을 해야하는지 노래 가사로 알려줘’ 같은 상상력이 필요한 영역부터 ‘직접 개발한 프로그래밍 언어의 스펙을 입력해서 인터프리터로 이용해 보기’, ‘기술 블로그를 작성해보기’ 등 기술적인 내용에 대한 솔루션을 제시할 수 있다는 점입니다. 어린 시절 쓴 일기를 챗GPT에게 학습시킨 뒤 어린 시절의 나와 실시간 대화를 해보는 활용하는 사례도 있었죠. 기존의 검색 엔진에서 볼 수 없었던 기능이죠. ChatGPT로 인해 파이썬처럼 쉬운 언어를 쓸 필요가 없는 시대가 다가올 수도 있다는 의견도 나오고 있습니다. DALL·E 2 등 AI 그림이 주는 놀라움에 이어, ChatGPT를 통한 AI 챗봇에 이르기까지 AI 기술의 변곡점(Inflection Point)이 찾아왔다는 생각이 들기도 하네요.

chatGPT 예시

ChatGPT의 단점과 한계

ChatGPT의 답변은 때때로 그럴듯하게 들리지만 부정확하거나 무의미한 내용일 수 있습니다. OpenAI 웹사이트에서도 진실에 대한 출처가 없는 강화학습 훈련의 특징에 따른 ChatGPT의 한계에 대해 명확하게 지적하고 있습니다. 종종 지나치게 장황하고 OpenAI에서 학습한 언어 모델이라고 다시 언급하는 등 특정 문구를 과도하게 사용합니다. 이러한 문제는 교육 데이터의 편향(트레이너는 더 포괄적으로 보이는 더 긴 답변을 선호함)과 잘 알려진 과도한 최적화 문제에서 발생하죠. 또한 유해한 지침에 응답하거나 편향된 행동을 보일 수 있습니다.

OpenGPT의 강화학습 알고리즘 (출처 : https://openai.com/blog/chatgpt/)

ChatGPT의 기술적 특징

ChatGPT는 텍스트를 생성하도록 훈련된 언어 모델인 GPT-3.5을 기반으로 하고 있습니다. GPT는 OpenAI사가 만든 언어예측 모델입니다. GPT는 생성하는(Generative) 사전 학습된(Pre-trained) 트랜스포머(Transformer)의 약자입니다. 어떤 텍스트가 주어졌을 때, 다음 텍스트가 무엇인지 예측하며 글을 생성할 수 있는 모델이죠. 일론 머스크가 만든 비영리 연구재단 OpenAI에서는 2018년에 GPT-1 출시 이후 2019년 GPT-2, 2020년 GPT-3에 이르기까지 버전업 될 때마다 인간이 쓴 글과 구분할 수 없을 정도로 수준 높은 글로 세상을 놀라게 했습니다.

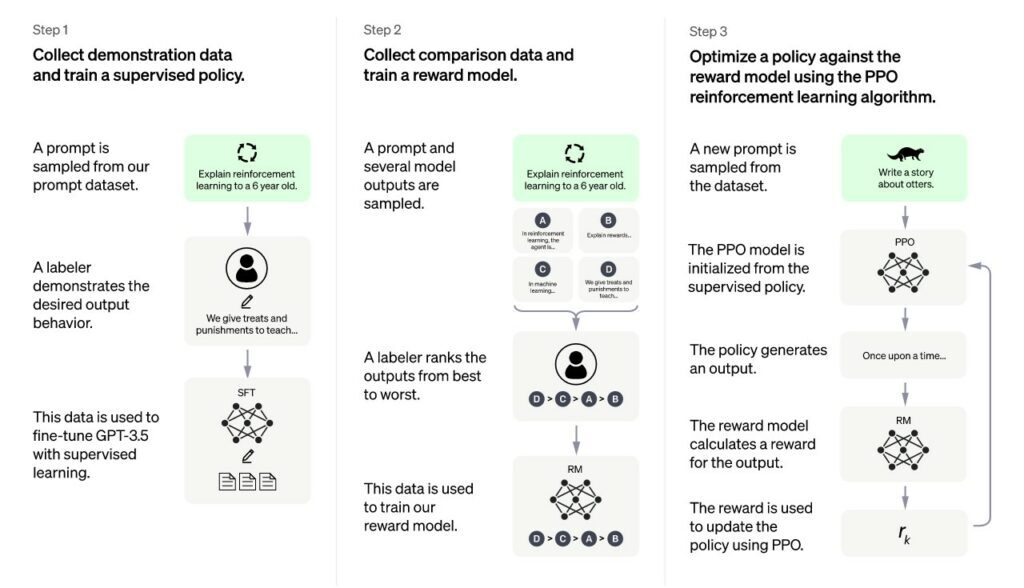

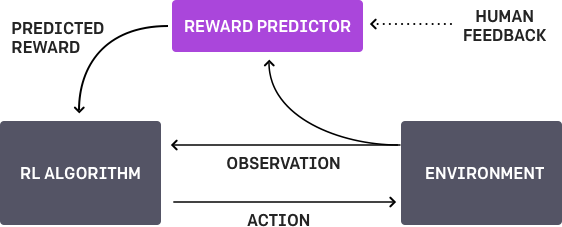

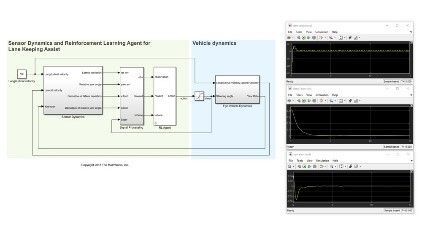

ChatGPT는 사람의 피드백을 활용한 강화학습(RLHF – Reinforcement Learning with Human Feedback)을 사용하여 대화에 최적화되었습니다. 강화학습(Reinforcement Learning)은 반복적인 시행착오 상호작용을 통해 작업 수행 방법을 학습하는 머신러닝 기법의 한 유형입니다. 강화학습으로 훈련된 심층 신경망은 복잡한 행동을 표현할 수 있습니다. 이를 통해 기존 방법으로는 해결하기 매우 까다롭거나 다루기 어려운 응용 분야에 대안적인 방식으로 접근할 수 있습니다. 예를 들어, 자율주행에서 신경망은 운전자를 대신하여 카메라 프레임, 라이다 측정값 등 다양한 센서를 동시에 살펴보고 핸들을 어떻게 돌릴지 결정할 수 있습니다.

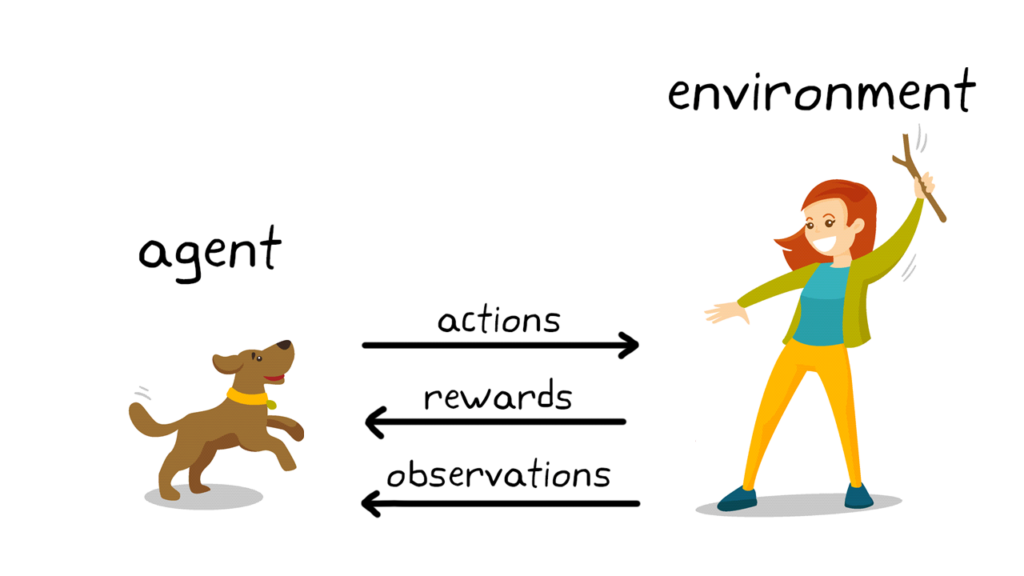

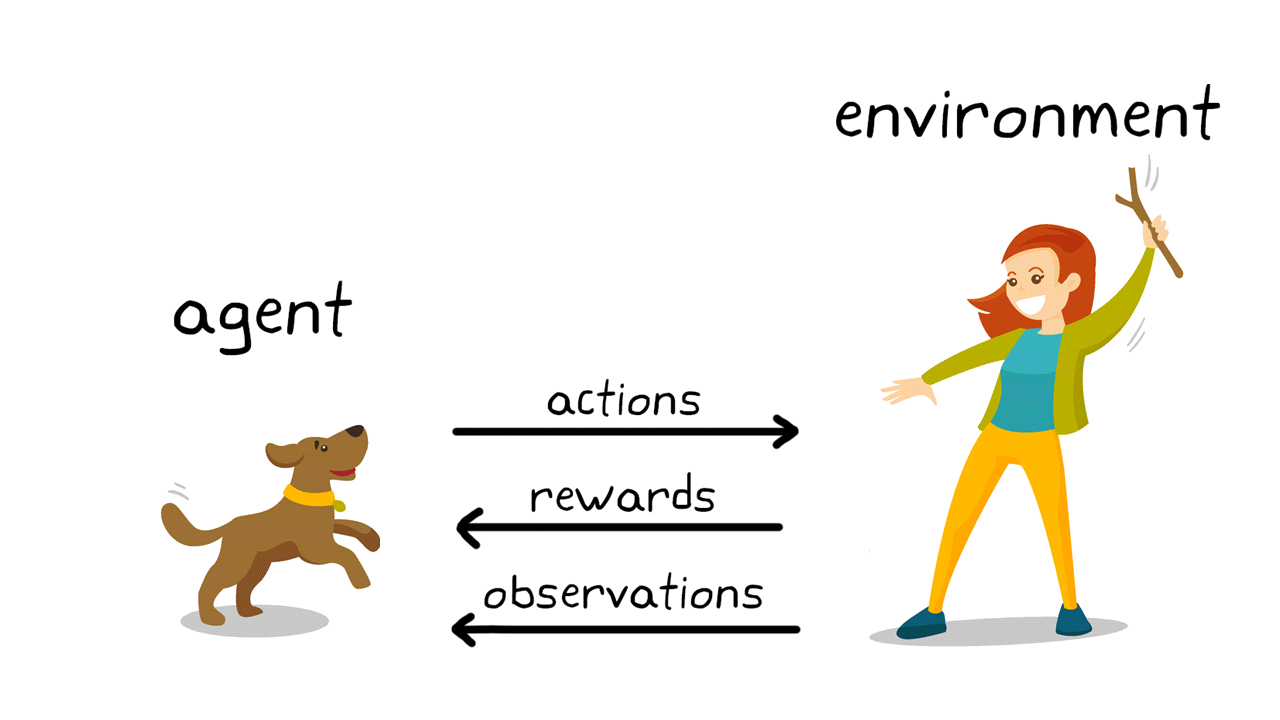

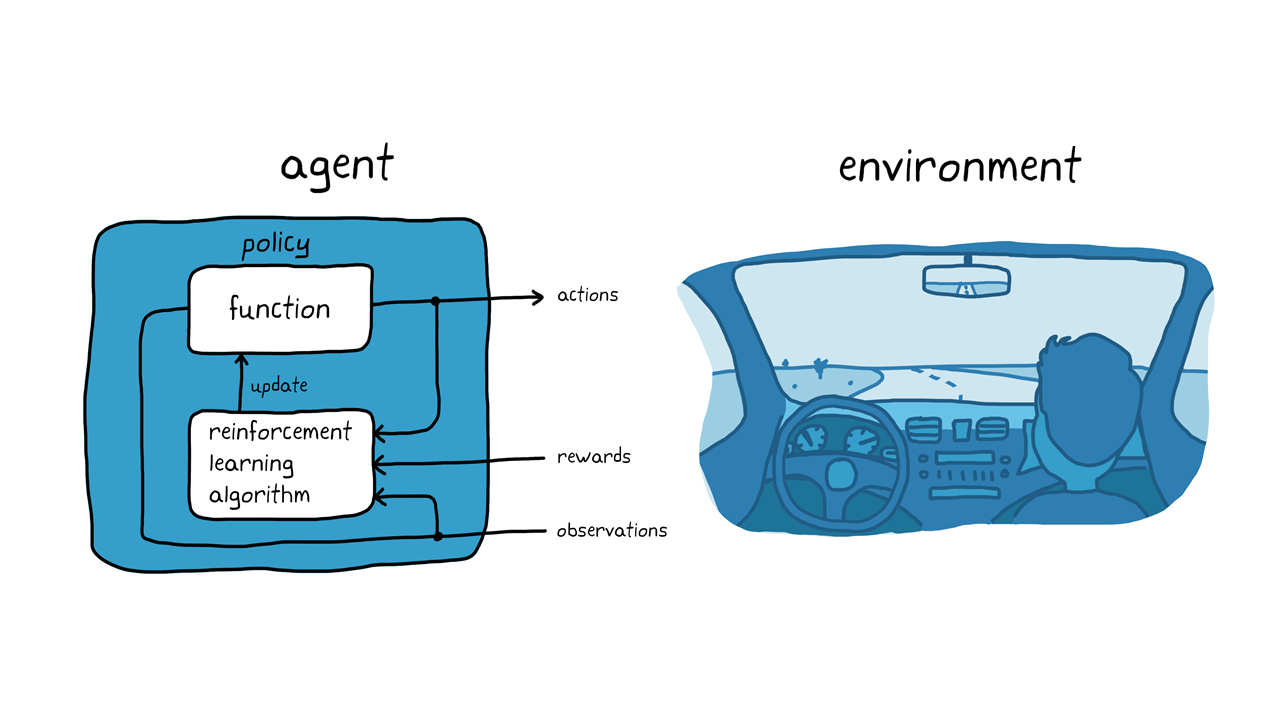

강아지(에이전트 agent)가 강아지를 둘러싼 환경과 훈련사를 포함한 환경에서 행동을 완료하도록 강아지를 훈련하는 과정을 강화학습으로 비유해볼 수 있습니다. 먼저 훈련사가 강아지에게 명령 또는 신호를 보내고 강아지는 이를 관찰(observations)합니다. 강아지는 행동(action)을 취하여 응답하고, 강아지의 행동이 원하는 행동과 근접한 경우 훈련사는 간식 또는 장난감과 같은 보상(rewards)을 제공하게 됩니다. 훈련 초반에 강아지는 특정 관측값을 행동 및 보상과 연관 짓기 위해서 ‘앉아’라는 명령에 구르는 등 무작위 행동을 더 많이 취하겠죠. 이러한 관측값과 행동 사이의 연관성 또는 매핑을 정책(policy)이라고 합니다. 강아지의 관점에서 최적의 시나리오는 모든 신호에 올바르게 응답하여 최대한 많은 간식의 획득입니다. 즉, 강화학습 훈련의 의미는 강아지가 보상을 최대화하는 목표 행동을 배울 수 있도록 강아지의 정책을 조정하는 데 있습니다. 훈련이 완료되면 강아지는 자신이 개발한 내부 정책을 사용하여 훈련사의 ‘앉아’라는 명령을 관찰하고 적절한 행동을 취할 수 있게 됩니다.

ChatGPT에서 사용된 사람의 피드백을 활용한 강화학습(RLHF – Reinforcement Learning with Human Feedback)을 도식화 한 그림입니다.

출처 : openai.com

ChatGPT를 통해 바라보는 앞으로의 미래

인공지능 기술이 콘텐츠 생산과 관련된 시간과 제한의 문턱을 크게 낮추면서, 앞으로는 인공지능과 협업할 수 있는 능력이 점점 더 중요해지는 시대가 도래했습니다. ChatGPT는 현재 사전체험 서비스 단계로, 회원 가입만 거치면 누구나 무료로 사용할 수 있습니다. 정식 서비스가 시작되면 유료화가 될 예정이죠. 본 글을 거의 마무리하기 전에 본 글의 내용에 대해서 ChatGPT를 통한다면 어떻게 글쓰기를 작성할까 궁금해져서 질문을 해봤습니다. 하지만 2021년 이후의 지식 범위라서 답변을 해줄 수 없다고 얘기하네요. 질문에 대한 답변 마무리로 ‘감사합니다’라고 표현하는 센스 또한 갖췄습니다. 인공지능 기술은 언제나 놀라움을 안겨주지만, 결국은 어떤 질문을 던지고 어떻게 활용할지에 대한 인간의 판단과 상상력이 점점 더 중요해진다는 생각이 들었습니다. ChatGPT를 통한 여러분들의 다양한 도전을 저도 기대해보겠습니다!

chatGPT 예시

ChtGPT와 같은 서비스를 직접 나도 만들어보고 싶다면? 인공지능 학습에 대한 열정이 있는 분들은 AI 학교 아이펠 캠퍼스를 참고해보세요.

** 본 블로그의 썸네일은 AI 이미지 제너레이터 DALL·E 2를 활용해서 만들었습니다.

강화학습이란?

꼭 알아야 할 3가지 사항사항

강화학습은 컴퓨터 에이전트가 역동적인 환경에서 반복적인 시행착오 상호작용을 통해 작업 수행 방법을 학습하는 머신러닝 기법의 한 유형입니다. 이 학습 접근법을 통해 에이전트는 인간 개입 또는 작업 수행을 위한 명시적인 프로그래밍 없이 작업에 대한 보상 메트릭을 최대화하는 결정을 내릴 수 있습니다.

강화학습으로 교육된 AI 프로그램은 바둑과 체스뿐만 아니라 비디오 게임에서도 사람을 상대로 승리했습니다. 강화학습은 새로운 개념이 아니지만 최근 딥러닝 및 계산 능력의 발전으로 인해 인공 지능 분야에서 매우 뛰어난 성과를 거뒀습니다.

강화학습이 중요한 이유

강화학습, 머신러닝 및 딥러닝

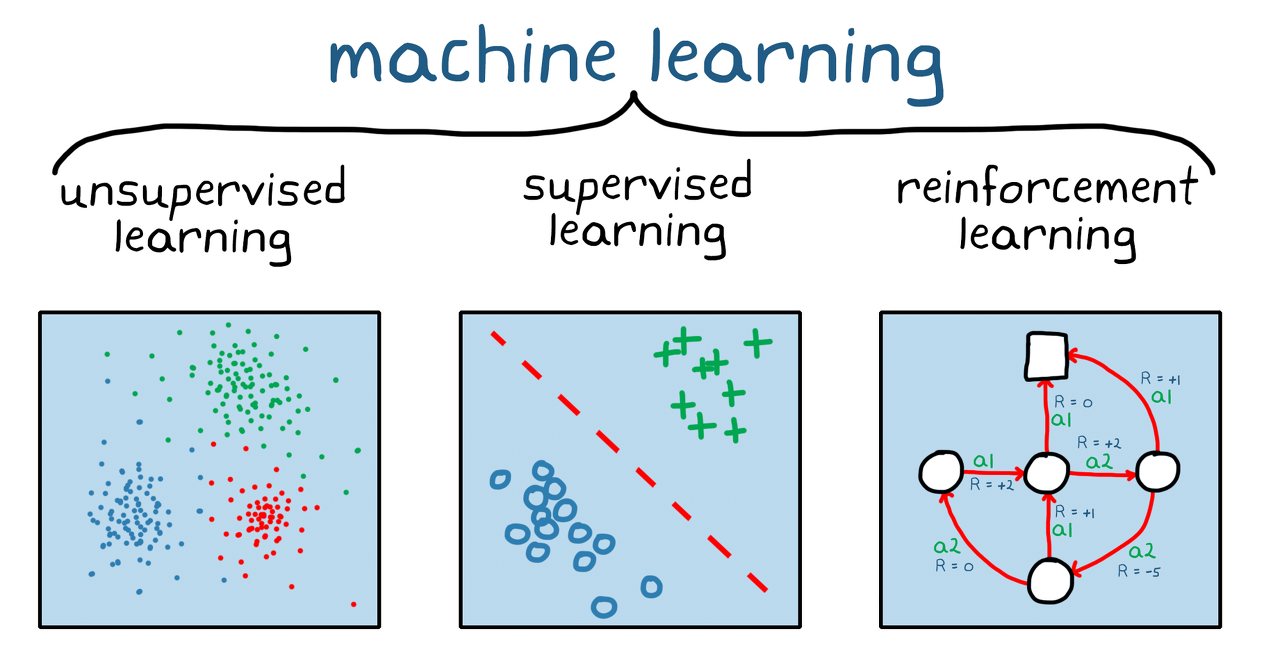

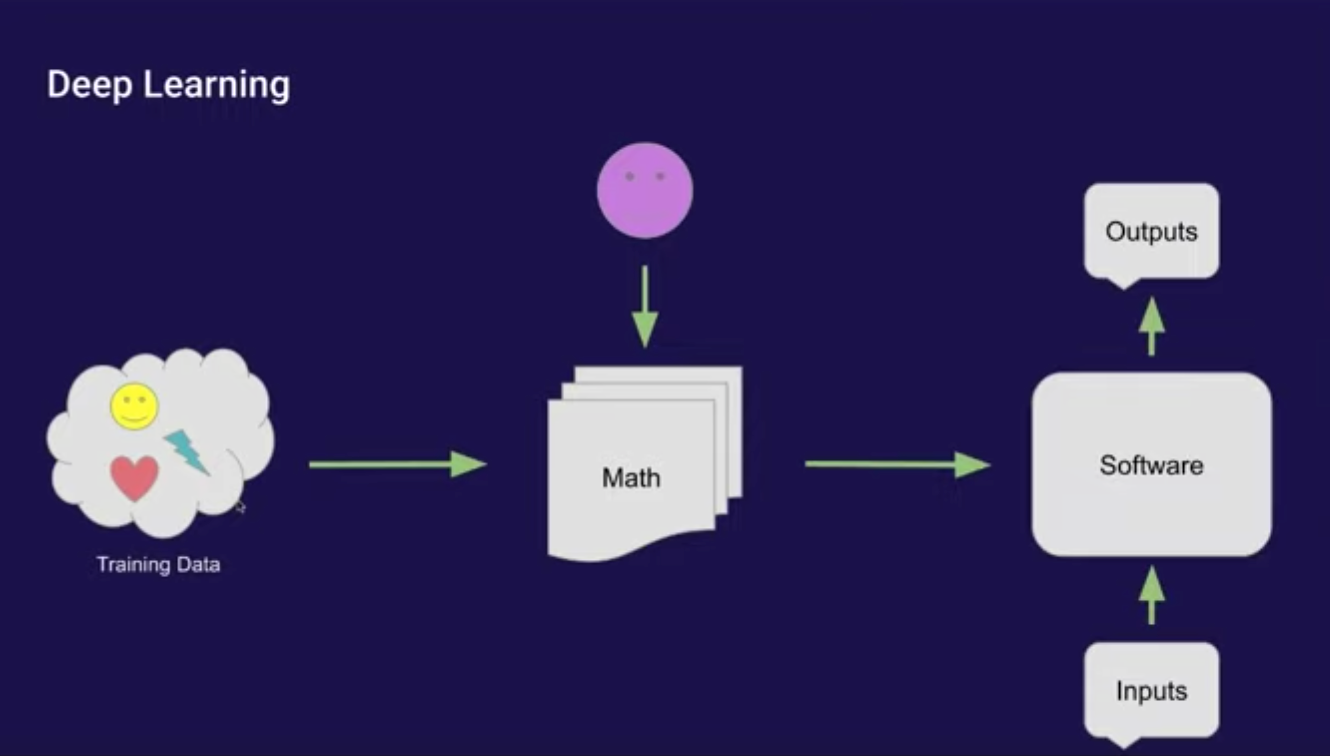

강화학습은 머신러닝의 한 부류입니다(그림 1). 비지도 및 지도 머신러닝과 다르게 강화학습은 정적 데이터셋에 의존하는 것이 아니라 역동적인 환경에서 동작하며 수집된 경험으로부터 학습합니다. 데이터 점 또는 경험은 훈련하는 동안 환경과 소프트웨어 에이전트 간의 시행착오 상호작용을 통해 수집됩니다. 강화학습의 이런 점은 지도 및 비지도 머신러닝에서는 필요한 훈련 전 데이터 수집, 전처리 및 레이블 지정에 대한 필요성을 해소하기 때문에 중요합니다. 이는 실질적으로 적절한 인센티브가 주어지면 강화학습 모델은 인간의 개입 없이 학습 행동을 자체적으로 시작할 수 있다는 것을 의미합니다.

딥러닝은 3가지 머신러닝 모두를 포함합니다. 강화학습과 딥러닝은 상호 배타적이지 않습니다. 복잡한 강화학습 문제는 주로 심층 강화학습이라고 알려진 분야인 심층 신경망에 의존합니다.

그림 1. 세 가지 머신러닝: 비지도 학습, 지도 학습 및 강화학습.

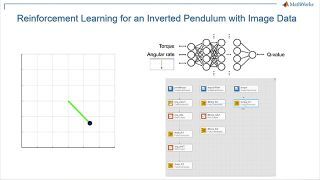

강화학습으로 훈련된 심층 신경망은 복잡한 행동을 표현할 수 있습니다. 이를 통해 기존 방법으로는 해결하기 매우 까다롭거나 다루기 어려운 응용 분야에 대안적인 방식으로 접근할 수 있습니다. 예를 들어, 자율주행에서 신경망은 운전자를 대신하여 카메라 프레임, 라이다 측정값 등 다양한 센서를 동시에 살펴보고 핸들을 어떻게 돌릴지 결정할 수 있습니다. 신경망이 없었다면 이 문제는 카메라 프레임에서 특징 추출, 라이다 측정값 필터링, 센서 출력값 통합, 센서 출력값을 기반으로 "주행" 결정 내리기 등의 여러 개의 작은 문제들로 세분화됐을 것입니다.

생산 시스템에서의 강화학습은 아직 증명이 되지 않은 접근법이지만 일부 산업 응용 분야는 강화학습을 활용하기 좋은 조건을 갖추고 있습니다.

고급 제어: 비선형 시스템을 제어하는 것은 매우 까다로운 문제로서 이는 주로 다양한 동작점에서 시스템을 선형화하여 해결합니다. 강화학습은 비선형 시스템에 바로 적용할 수 있습니다.

자율주행: 카메라 입력값을 기반으로 주행 결정을 내리는 이 분야는 심층 신경망이 영상 응용 분야에서 거둔 성공을 고려하면 강화학습에 잘 맞는 분야입니다.

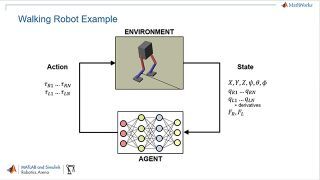

로봇공학: 강화학습은 픽앤플레이스 응용 분야에서 로봇 팔로 다양한 사물을 다루는 방법을 학습시키는 등 로봇 파지와 같은 응용 분야에서 사용될 수 있습니다. 다른 로봇공학 응용 분야로는 인간-로봇, 로봇-로봇 협업이 있습니다.

스케줄링: 스케줄링 문제는 신호등 제어, 특정 목표를 위해 공장 현장의 리소스 편성 등 다양한 시나리오에 존재합니다. 강화학습은 이와 같은 조합 최적화 문제 해결에 있어 진화적 방법을 대체할 수 있는 좋은 수단입니다.

보정: ECU(Electronic Control Unit) 보정과 같이 파라미터의 수동 보정이 필요한 응용 분야는 강화학습을 활용하기 좋은 조건을 갖추고 있습니다.

강화학습의 작동 방식

강화학습의 훈련 메커니즘은 다양한 실제 시나리오를 반영합니다. 긍정 강화를 통한 반려동물 훈련을 예시로 들어보겠습니다.

그림 2. 강아지 훈련의 강화학습.

강화학습 용어(그림 2)를 사용해서 설명하자면 이 사례의 학습 목표는 강아지(에이전트) 가 강아지를 둘러싼 환경과 훈련사를 포함한 환경에서 행동을 완료하도록 강아지를 훈련하는 것입니다. 먼저 훈련사가 강아지에게 명령 또는 신호를 보내고 강아지는 이를 관찰합니다(관측값). 그런 다음 강아지는 행동을 취하여 응답합니다. 취한 행동이 원하는 행동과 근접한 경우 훈련사는 간식 또는 장난감과 같은 보상을 제공할 것입니다. 그렇지 않다면 보상이 제공되지 않습니다. 훈련 초반에 강아지는 특정 관측값을 행동 및 보상과 연관 짓기 위해서 "앉아"라는 명령에 구르는 등 무작위 행동을 더 많이 취할 것입니다. 이러한 관측값과 행동 사이의 연관성 또는 매핑을 정책이라고 합니다. 강아지의 관점에서 최적의 시나리오는 모든 신호에 올바르게 응답하여 최대한 많은 간식을 획득하는 것입니다. 즉, 강화학습 훈련의 의미는 강아지가 보상을 최대화하는 목표 행동을 배울 수 있도록 강아지의 정책을 "조정"하는 데 있습니다. 훈련이 완료되면 강아지는 자신이 개발한 내부 정책을 사용하여 보호자의 "앉아"라는 명령을 관찰하고 적절한 행동을 취할 수 있게 됩니다. 이 시점에는 간식이 제공되면 좋지만 필수적이지 않습니다.

강아지 훈련 예시를 떠올리면서 자율주행 시스템을 사용한 자동차 주차 작업의 예시를 살펴보겠습니다(그림 3). 목표는 강화학습을 활용하여 자동차 컴퓨터(에이전트)에게 올바른 주차 위치에 주차하도록 가르치는 것입니다. 강아지 훈련 사례와 동일하게 환경은 에이전트를 제외한 모든 것을 의미하며 차량의 동특성, 근처에 있는 다른 차량, 날씨 등이 포함될 수 있습니다. 훈련 동안 에이전트는 카메라, GPS 및 라이다 등 센서의 판독값(관측값)을 사용하여 운전, 제동 및 가속 명령(행동)을 생성합니다. 관측값으로부터 올바른 행동을 생성하는 방법을 학습(정책 조정)하기 위해 에이전트는 시행착오 절차를 통해 차량의 주차를 반복해서 시도합니다. 시행의 적합성을 평가하고 학습 과정을 인도하기 위해 보상 신호가 제공될 수 있습니다.

그림 3. 자율주차의 강화학습.

강아지 훈련 예시에서 훈련은 강아지 뇌 속에서 이뤄졌습니다. 자율주행 예시에서는 훈련 알고리즘이 훈련을 담당합니다. 훈련 알고리즘은 수집된 센서 판독값, 행동 및 보상을 기반으로 에이전트의 정책 조정을 책임집니다. 훈련이 완료되면 차량의 컴퓨터는 조정된 정책과 센서 판독값으로만 주차를 할 수 있습니다.

유념해야 될 점은 강화학습은 샘플 효율적이지 않다는 점입니다. 이는 훈련을 위한 데이터를 수집하려면 에이전트와 환경 사이에 수많은 상호작용이 필요하다는 것을 의미합니다. 예를 들어 세계 바둑 챔피언을 상대로 승리한 최초의 컴퓨터 프로그램인 AlphaGo는 며칠 동안 쉬지 않고 훈련하여 수백만 판의 대국을 둬서 수천 년간의 인간 지식을 축적하였습니다. 비교적 간단한 응용 분야에 대해서도 훈련 시간은 몇 분에서 몇 시간, 며칠까지 소요됩니다. 또한 내려야할 수많은 설계 결정이 있는데 이런 모든 결정을 올바르게 내리기 위해서는 몇 번의 시도가 필요할 수도 있기 때문에 문제를 제대로 설정하는 것 또한 까다로울 수 있습니다. 이런 결정에는 적절한 신경망 아키텍처 선택, 하이퍼파라미터 조정 및 보상 신호 형성 등이 있습니다.

강화학습 워크플로

강화학습을 사용한 에이전트 훈련의 일반적인 워크플로는 다음과 같은 단계를 포함합니다(그림 4).

그림 4. 강화학습 워크플로.

1. 환경 생성

먼저 에이전트와 환경 간 인터페이스 등의 강화학습 에이전트가 운영될 환경을 정의해야 합니다. 이 환경은 시뮬레이션 모델 또는 실제 물리적 시스템일 수 있으나 더욱 안전하고 실험이 가능한 시뮬레이션 환경이 일반적으로 더 좋은 첫 단계입니다.

2. 보상 정의

다음으로 에이전트가 성과를 작업 목표와 비교하기 위해 사용할 보상 신호 및 이 신호를 환경으로부터 계산하는 방법을 명시해야 합니다. 보상을 형성하는 것은 까다로운 작업이며 올바르게 설정하기 위해 몇 번의 시도가 필요할 수도 있습니다.

3. 에이전트 생성

그런 다음 정책과 강화학습 훈련 알고리즘으로 구성된 에이전트를 생성합니다. 그러기 위해선 다음을 완료해야 합니다.

a) 정책을 나타낼 방법 선택(신경망 또는 룩업 테이블 사용 등).

b) 적절한 훈련 알고리즘 선택. 각각의 표현 방식은 대개 각각의 특정 훈련 알고리즘의 범주와 연결되어 있습니다. 그러나 일반적으로 대부분의 최신 강화학습 알고리즘은 대규모 상태/행동 공간 및 복잡한 문제에 적합한 신경망에 의존합니다.

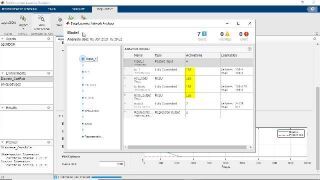

4. 에이전트 훈련 및 검증

훈련 옵션(중지 기준 등)을 설정하고 에이전트를 훈련해 정책을 조정합니다. 훈련이 종료된 후에는 훈련된 정책을 꼭 검증하여야 합니다. 필요에 따라 보상 신호 및 정책 아키텍처 등의 설계 선택을 다시 검토하고 재훈련합니다. 강화학습은 일반적으로 샘플 비효율적으로 알려져 있습니다. 훈련은 응용 분야에 따라 몇 분에서 며칠까지 소요됩니다. 복잡한 응용 분야의 경우 여러 CPU, GPU 및 컴퓨터 클러스터에서 훈련을 병렬 처리하여 가속할 수 있습니다(그림 5).

그림 5. 병렬 연산으로 샘플 비효율적인 학습 문제 훈련.

5. 정책 배포

훈련된 정책 표현을 C/C++ 또는 CUDA 코드로 생성하여 배포합니다. 이 시점에서 정책은 독립된 의사 결정 시스템입니다.

강화학습을 사용하여 에이전트를 훈련하는 절차는 반복적인 과정입니다. 추후 단계의 결정 및 결과로 인해 학습 워크플로의 이전 단계로 다시 돌아와야 할 수 있습니다. 예를 들어 훈련 과정에서 합리적인 시간 안에 최적의 정책으로 수렴하지 않는 경우 에이전트를 재훈련하기 전에 다음과 같은 사항을 업데이트해야 할 수 있습니다.

훈련 설정

강화학습 알고리즘 구성

정책 표현

보상 신호 정의

행동 및 관측값 신호

환경 동특성

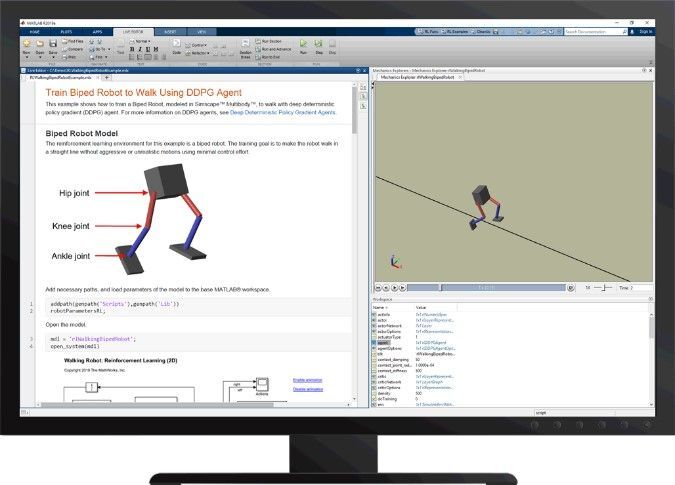

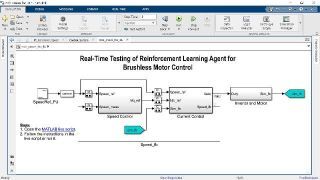

MATLAB 및 Simulink를 통한 강화학습

MATLAB® 및 Reinforcement Learning Toolbox™는 강화학습 작업을 간소화합니다. 강화학습 워크플로의 모든 단계를 거치면 로봇 및 자율주행과 같은 복잡한 시스템을 위한 컨트롤러 및 의사결정 알고리즘을 구현할 수 있습니다. 구체적으로 다음과 같은 단계를 수행할 수 있습니다.

1. MATLAB 및 Simulink®를 사용하여 환경 및 보상 함수 생성

2. 심층 신경망, 다항식, 룩업 테이블을 사용하여 강화학습 정책 정의

그림 6. Reinforcement Learning Toolbox™로 이족 보행 로봇에게 보행 가르치기

3. 약간의 코드 변경만으로 DQN, DDPG, PPO 및 SAC와 같은 널리 쓰이는 강화학습 알고리즘을 전환, 평가 및 비교 또는 나만의 사용자 지정 알고리즘 생성

4. Parallel Computing Toolbox™ 및 MATLAB Parallel Server™를 사용해 여러 GPU, CPU, 컴퓨터 클러스터 및 클라우드 리소스를 활용하여 강화학습 정책을 더욱 빠르게 훈련

5. MATLAB Coder™ 및 GPU Coder™를 통해 코드를 생성하고 임베디드 기기로 강화학습 정책 배포

6. 참조 예제를 사용하여 강화학습 시작

바로 시작해 보십시오

Reinforcement Learning Onramp

제어 문제에 대한 강화 학습 방법을 학습하며 시작할 수 있습니다.

강화학습에 대해 자세히 알아보기

관련 주제

인공 지능

딥러닝

머신러닝

Reinforcement Learning

이 시리즈는 전통적 기법으론 풀어내기가 너무 까다로운 몇몇 제어 시스템 문제에 해결 가능성을 제시하는 머신러닝 유형인 강화 학습에 대한 개요를 제공합니다. 여기서는 강화 문제의 기본

kr.mathworks.com

마이크로소프트가 개발한 중국 AI 로봇 '샤오이스'는 100시간 동안 519개의 작업 개수 편을 학습한 결과만 가능하다고 판단됩니다. 시집의 제목은 '햇살은 유리창을 최대한(Sunshine Misses Windows)'. 샤오이가 최근에 한 페이지 중국에서 6억 명이 급증한 사용자들이 사용하는 서비스가 되었습니다.

가끔 심심할 때 집에서 인공 지능 스피커와 대화하는 동안의 경험 한 일시적으로라도 계실 텐데. 말을 못 알아들을 때 스피커를 놀리는 재미가 쏠 수 있는 전기를 쏠 수 있습니다. 지금이야 말을 못 알아듣는 경우가 더 많은 인공지능이 사람처럼 말을 하고 글을 쓸 수 있다면? 정말 우리의 일상생활을 함께 할 수 있는 친구 같은 만남이 될 수 있습니다.

언어는 인간을 다른 동물과 구별하는 가장 큰 사회적 도구입니다. 그런 인공지능이 말을 끊다고요?

인공 지능이 언어 모델(Language Model)을 발전시키는 데는 크게 2가지 방법이 있습니다. 1)사람의 언어를 수치적으로 활용하는 방법이 될 것입니다. 여러분도 많이 들어보셨겠지만 최근에는 '인공 신경망'을 이용한 방법이 더 좋은 성과를 보여주고 있습니다. 단순하게는 우리가 입력한 단어의 다음 단어가 무엇일지 예측할 수 있는 연구와 같은 화면의 언어 모델에서 이제 사람처럼 글도 머리를 쓰는 말에 점점 인공 지능의 언어 모델은 인간에게 어떤 의미가 있는 지 이야기해 봅니다. 완전히 적대적인 것입니다.

오늘 이야기할 주인공은 바로 이 인공신경망을 이용한 언어 GPT입니다. AI 네트워크가 만든 AI Writer도 GPT 2를 기반으로 만들어졌습니다. 일론스크 머가 만든 플러그인 연구 재단 Open AI가 만든 공개 모델을 만들 수 있습니다. 그것이 폭로되고 나서 GPT는 첫 번째 공개에 이어 2번째, 3번째까지 폭로된 상황이고 계류 GPT 4에 대한 이야기도 솔솔 다가오고 있습니다.

2.GPT 발전의 타임라인

GPT라는 언어 모델은 자연어 처리의 기반이 되는 조건부 예상 가능한 도구입니다. 사람처럼 문장 자체를 이해하고 써지는 건 아니죠. 여러 개의 텍스트 데이터를 분석해서 뽑아낸 문장을 만들 수 있다고 합니다. 우리처럼 글을 읽고 다시 머리를 쓰고 머리에 딱 붙는 매커니즘은 섹시하지 않습니다. 우리가 키워드를 입력하면 그 키워드와 관련된 모든 자료를 취합하여 사람이 요구하는 텍스트를 만들어 내는 것일 요청합니다. 글은 그 사람을 보내는 사람이 말이 되는 인공지능이고 통하는 말인 듯 합니다.

인간 그럼에도 불구하고 구분할 수 없는 글을 써내려갈 수 있는 비결은 그래도 어마한 학습량입니다. Open AI가 2018년 첫 반납한 GPT 1은 1억 1700만개 운영으로 학습했습니다. 일이 2019년 Open AI는 4번에 걸쳐 GPT 2를 공개했습니다. 모델 크기에 따라 약 1억 2400만 개에서 15억 개로 앞선 가변의 10배 수준으로 인간과 비슷한 수준의 글로 한 책 페이지의 한계를 단 10초 만에 만들 수 있는 수준이라고 합니다. 이제 전기까지 인공 지능이 복제하는 것이냐 양성을 줄만 합니다. 여기서 끝이 아니었습니다. GPT 3는 1750억개를 유지하고 있습니다. GPT 1의 1000배, GPT 2의 100배 이상의 크기로 그 사이 성능도 크게 향상되었습니다. GPT 3가 가능하고 다양한 작업이 가능한 언어 관련 문제풀이, 임의의 글짓기, 단순 사칙연산, 번역문, 주어진 문장에 그림을 간단하게 웹핑이 라고 합니다.

3. GPT 3의 서열은?

GPT 3의 기반은 트랜스포머(transformers)라든 딥러닝 체계입니다. 전송포머에 대한 개념은 2017년 Google 브레인(Google Brain)이 발간한 보고서 '필요한 것은 집중(Attention is all you need)'에서 처음 소개받았습니다. 다양한 모델의 밑거름이 들어있습니다. Google 보고서가 발간된 이후 다양한 언어 작업을 처리할 수 있는 슈퍼 모델을 구축하기 위한 경쟁이 치열해 보이지만 잘 알 수 있습니다. 구글의 버트(BERT), 마이크로소프트의 튜링링NLG 와 Open AI의 GPT 3 모두 트랜스포머를 기반으로 하는 최신 모델인데요. GPT3가 이전에 가장 큰 언어 모델은 2020년 마이크로소프트가 접인 튜너링 NLG였습니다. 170억개로 구성된 GPT3보다 10배나 크기가 작습니다. GPT3가 출시자 마이크로소프트는 경쟁을 포기하고 강력한 사용권을 얻었고 유지했습니다. (확실히 일론 머스크는 와이셔츠를 잡아 당겼어요) Google도 언어모델 BERT를 찾을 수 있습니다. 검색엔진 특유의 뉘앙스와날을 잘 이해해서 찾아낸 결과를 내는데 도움을 주죠. .

4.GPT 3를 공개한 이유는?

지난 OPEN AI는 반대와 반대로 GPT 3 모델을 오픈 소스로 폭로하는 걸 꺼려왔습니다. 홈페이지를 API를 통해 공개하는 이유에 대해 이렇게 밝혔습니다. 기술을 지속화하면 AI 개발을 유지하고 비용을 절약할 수 있고 장력이 있는 자원을 함께 전환하는 개념으로 끌어올리고 원을 잡습니다. API를 통해 공개하면 오남용 사례를 세울 수 있다고도 봤다. 오픈소스화하면 시각장애인 사용 사례를 부족할 수 있습니다.

5.GPT 3의 끝은?

하지만 아직까지는 존재합니다. 먼저 암호 가능성이 있는 것 외에는 불가능합니다. 상당한 양의 전력을 복구하는 데 필요한 상황인 찾기. GPT 3만 나왔을 때 1750억 개의 농민을 공부했습니다. 150억개 가능한 학습을 GPT 2와 비교했다면 거의 100배가 가능할 수 있습니다. . _ 많은 돈은 충분한 충분한 증거이기도 하지만 결국 배당과 활용 가능성만큼 어렵다는 이야기가 필요합니다.

일례로 마이크로소프트가 OPEN AI에게 제공하고 있는 애저 AI 슈퍼 컴퓨터는 28만 5천 이상의 CPU 코어를 가지고 1만 GPU가 400Gbps 네트워크로 연결됩니다. 머신러닝이 결국 최소의 개별 AI모델보다 개별적인 최대 모델이 더 나은 상호작용을 내는 생성된 결과이다보니 결국 그만큼 '모두를 위한 AI' 개발에서 멀어질 수는 없습니다.

기술적으로 그렇다죠. 사람들은 GPT 3를 계속 인간의 직업을 보존하고 오래 유지하고 걱정하고 두려워하지만 사실 GPT 3은 주어진 단어에 대해 통계적으로 가장 일치하는 다음 단어를 생성하는 것뿐이고 이해하는 것은 존재하지도 않습니다. 생각과 이해는 친구의 영역을 설명합니다. 질문 건 우리 인간은 다음 단어를 예측하는 방법으로 언어 해석을 하지 않았다는 점입니다.

6.GPT-4는?

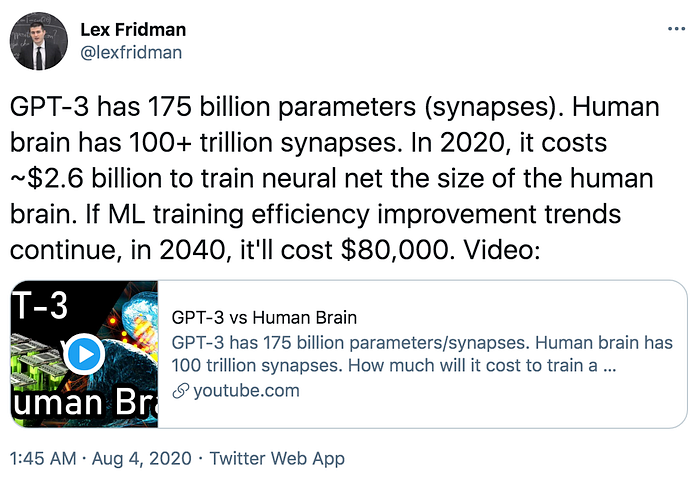

MIT의 렉스 프리드만 교수는 2020년 기준으로 인간 뇌의 인공 지능을 훈련시키려면 26억 달러, 원화로 2조 원이런 돈이 들지만 2040년이 되면 8만 달러, 약 8000만원이면 가능해질 때까지 복구 내다. 결국 GPT 3에 이어 공개될 GPT 4는 더 큰 비용으로 더 큰 현금을 줄 가능성이 있습니다. 그래도 여전히 인공 지능의 훈련에 자금과 막대한 자원이 많이 죽어야 합니다.

우리의 AI 네트워크와 함께라면 찾아보세요. 생각보다 쉬운 문제가 풀릴 지 턱. 손상된 의미의 OPEN AI를 만들 수 있습니다. 세계를 연결하는 컴퓨터를 만들고 있습니다. 글로벌 개발자와 자원 제공자가 힘을 합당한 경우 마이크로소프트의 슈퍼 컴퓨터를 능가하는 구속력을 만들 수 있겠습니까? 우리 모두가 협력하여 '집단 지성'으로 OPEN AI가 우려하는 나쁜 AI를 펼칠 수도 있을거고요.

여러분의 의견이 됩니다! 여러분의 생각은 깨지신가요? 함께 감상해주세요^^

AI 네트워크는 블록체인 기반 플랫폼으로 인공 지능 개발 환경의 핵심을 목표로 하고 있습니다. 수백만 개의 오픈 소스 프로젝트가 라이브로 구현되는 글로벌 백엔드를 표방합니다.

Chrome용 AI 작성기

AI로 글을 완성하세요. AI Writers는 Machine을 사용하여 텍스트 자동 완성 기능을 제공하는 작문 도우미입니다.

chrome.google.com

AI 네트워크 생태계

AI Network는 개발자, GPU, 개발 리소스, 크리에이터 기반 데이터를 한 곳에 모아 모두에게 개방된 분산형 AI 개발 생태계입니다. 모두를 위한 AI를 구현하는 '협업 AI'의 미래를 나타냅니다.

더 발견하다

'say와 AI 챗봇친구 만들기 보고서' 카테고리의 다른 글

| ChatGPT-5의 힘 발휘 [효율성 및 지속 가능성 향상] (0) | 2023.06.29 |

|---|---|

| 네이버·카카오, 하반기 'AI 챗봇' 공개 [한국산 챗GPT 어디까지 왔나···] (0) | 2023.06.29 |

| [인공지능] 마이크로소프트 코파일럿 [AutoGPT가 왔다 (설치 및 사용팁)] (0) | 2023.06.28 |

| 챗GPT-5 멀티모달 기술 [6월 4주차 인공지능 뉴스레터] (0) | 2023.06.27 |

| 실생활에서의 양자 컴퓨팅 응용: 산업 변화 및 가능성 향상 (0) | 2023.06.26 |