스마트시티 비전 추구하는 스타트업 투아이, 작업자 안전에 AI 적용

Julien Trombini와 Guillaume Cazenave는 4년 전 비디오 분석 스타트업인 Two-i를 설립했을 때 야심 찬 목표를 가지고 있었습니다. 그것은 언젠가 도시의 도로, 쓰레기 수거 및 기타 공공 서비스를 모니터링할 수 있게 하여 도시 생활의 질을 향상하는 것이었습니다.

그 과정에서 두 사람은 완전히 다른 틈새 시장을 발견했습니다. 오늘날 컴퓨터 비전, 데이터 과학, 딥 러닝을 결합한 회사의 기술은 세계에서 가장 위험한 부문 중 하나인 석유 및 가스 산업에서 치명적인 사고를 예방하는 데 도움을 주고 있습니다.

처음에 Trombini와 Cazenave는 시민 지도자들이 지방자치단체 전체에 어떤 개선이 필요한지 확인할 수 있는 시스템을 구상했습니다.

프랑스 북동부의 역사적인 도시인 메츠에 본사를 둔 NVIDIA Metropolis 파트너인 Two-i의 회장을 맡고 있는 Trombini는 "그것은 효율성을 측정하는 유일한 도시의 기상 지도를 갖는 것과 같을 것입니다."라고 말했습니다.

이는 어려운 주문이었기 때문에 두 사람은 경기장, 은퇴자 주택, 환승역과 같은 특정 시설에 다시 초점을 맞춰 기술이 보안 및 사고 감지에 도움이 되었습니다. 예를 들어, 양로원 거주자가 복도에 떨어지면 적절한 사람에게 경고를 보낼 수 있습니다. 또는 휠체어를 사용하는 대중교통 승객이 리프트 고장으로 인해 열차에 탑승할 수 없는 경우.

최근에는 ExxonMobil이 잠재적으로 치명적인 문제인 개방형 오일 탱크 주변의 작업자 안전을 개선하는 데 도움을 주기 위해 회사에 접근했습니다.

Two-i는 거대 에너지 기업과 함께 개인이 위험 구역 근처에 있을 때 넘어질 위험이 있는지를 감지하고 즉시 다른 사람들에게 빠른 조치를 취하도록 경고하는 AI 지원 비디오 분석 애플리케이션을 만들었습니다. 비전 AI 시스템은 운영 초기 몇 달 동안 2건의 사고를 예방했다.

이 사용 사례는 매우 구체적이지만 회사의 AI 아키텍처는 다양한 알고리즘과 기능을 유연하게 지원하도록 설계되었습니다.

“알고리즘은 우리가 다양한 클라이언트에 사용하는 것과 정확히 동일합니다.”라고 Trombini는 말했습니다. “동일한 기술이지만 패키지 방식이 다릅니다.”

Vision AI 최대한 활용하기

Two-i의 유연성은 AI 지원 비디오 분석 애플리케이션을 위한 NVIDIA Metropolis 플랫폼 사용 , 고급 도구 활용 및 풀 스택 접근 방식 채택에서 비롯됩니다.

이를 위해 훈련과 추론 모두에 고성능 NVIDIA Ampere 아키텍처 기반의 최신 워크스테이션과 데이터 센터 GPU를 사용하는 다양한 NVIDIA 인증 시스템을 사용합니다. 훈련 시간을 더욱 단축하기 위해 Two-i는 강력한 NVIDIA A100 GPU에서 대규모 이미지 데이터 세트를 테스트하려고 합니다.

이 회사는 시스템에 데이터를 공급하는 카메라 수에 관계없이 고객에게 가장 빠른 설루션을 제공할 수 있도록 GPU를 자주 업그레이드하려고 합니다.

Trombini는 "시간을 절약하는 것이 매우 중요합니다. 하드웨어가 좋을수록 결과가 더 정확해지고 시장 출시도 빨라집니다."라고 말했습니다.

Two-i는 CUDA 11.1 툴킷과 cuDNN 8.1 라이브러리를 활용하여 딥 러닝 프로세스를 지원하고 NVIDIA TensorRT를 활용하여 추론 처리량을 가속화합니다.

Trombini는 NVIDIA 기술의 가장 매력적인 부분 중 하나가 NVIDIA TAO 툴킷이라고 말합니다. 이 툴킷은 회사가 알고리즘을 수정하면서 비용을 절감하는 데 도움이 됩니다.

“알고리즘이 무거울수록 비용이 더 많이 듭니다.”라고 그는 말했습니다. "우리는 TAO 툴킷을 사용하여 알고리즘을 정리하고 작업에 더욱 적합하게 만듭니다."

예를 들어, 처음에는 최대 2주까지 걸리던 교육이 NVDIA 교육, 적응 및 최적화 프레임워크의 CLI 및 Jupyter 노트북 기반 버전인 NVIDIA TAO 툴킷을 사용하여 3일로 단축되었습니다.

Two-i는 또한 알고리즘에 대해 NVIDIA의 사전 훈련된 모델을 벤치마킹하기 시작했으며 NVIDIA DeepStream SDK를 사용하여 비디오 분석 파이프라인을 향상하기 시작했습니다.

성공을 기반으로

Two-i는 ExxonMobil과 같은 다양한 환경에서 복잡한 문제를 해결하는 능력을 원래의 스마트 시티 열망으로 되돌릴 수 있는 발판으로 보고 있습니다.

이미 유럽 8개 도시의 모든 도로를 모니터링하고 교통 흐름을 분석하며 자동차가 어디에서 오고 가는지 파악하고 있습니다.

Trombini는 Two-i가 회사의 장기적인 목표를 달성하기 위해 계속해서 혜택을 제공하는 데 초점을 맞춰야 한다는 점을 인식하고 있습니다.

“천천히 진행되고 있지만 우리는 우리의 비전을 구현하기 시작했습니다.”

스마트시티 비전 추구하는 스타트업 투아이, 작업자 안전에 AI 적용

반짝이는 호수에 투영된 눈 덮인 뾰족한 산봉우리의 모습. 초보 화가는 이런 멋진 일몰 풍경을 담아내기 위해 캔버스에 붓질을 합니다. 하지만 여러 색상의 물감이 덧대진 서투른 그림만 남게 되죠.

엔비디아 리서치가 개발한 딥 러닝 모델 툴을 사용하면 누구나 멋진 그림 작업을 할 수 있답니다.

대충 그려도 입이 딱 벌어지는 사실적인 작품을 탄생시키죠. 이 도구는 GAN (Generative Adversarial Networks)이라고 불리는 생성적 적대 신경망을 활용해 분할 지도를 실제 같은 이미지로 변환시킵니다.

이 모델을 사용한 인터렉티브 앱은 후기 인상파 대표 화가인 폴 고갱의 이름을 따 고갱(GauGAN)으로 불립니다.

GauGAN은 건축가, 도시 계획자부터 조경 설계자와 게임 개발자에 이르는 모든 이들에게 가상 세계를 만들 수 있는 강력한 도구를 제공할 수 있습니다. 현실 세계의 모습을 파악한 AI를 활용해 전문가들은 아이디어를 한층 수월하게 프로토타이핑 할 수 있으며 합성 장면으로 빠르게 전환시킬 수 있죠.

브라이언 카탄자로(Bryan Catanzaro) 엔비디아 응용 딥 러닝 연구소 부사장은 “간단한 스케치로 디자인을 브레인스토밍 하기가 매우 쉬워졌습니다. 이 기술로 스케치를 매우 사실적인 이미지로 만들어 낼 수 있죠”라고 말했습니다.

브라이언 카탄자로 부사장은 GauGAN에 적용된 기술을 개략적인 분할 지도 내에 세부사항을 채울 수 있는 “스마트 페인트브러시”에 비유했습니다. 장면 속 물체의 위치를 보여주는 정밀한 윤곽 표현 기술이죠.

사용자들은 GauGAN으로 분할 지도를 그리고 장면을 조정해 모래, 하늘, 바다, 눈 등으로 영역별 라벨링을 할 수 있습니다.

수백만 개 이미지로 트레이닝된 이 딥 러닝 모델은 뛰어난 결과물로 장면을 연출해 냅니다. 연못을 그리고, 그 주변을 둘러싼 나무와 바위 등이 물에 비친 모습도 나타나죠. 영역 라벨을 “잔디”에서 “눈”으로 바꾸면 전체 이미지는 한 겨울로 변신합니다. 잎이 무성한 나무도 앙상한 가지만 남은 나무가 되죠.

브라이언 카탄자로 부사장은 “나무가 있는 곳, 해가 있는 곳, 하늘이 있는 곳 등을 표시하는 색칠하기 책과 같습니다. 그 작업이 끝나면 뉴럴 네트워크가 실제 이미지에서 학습한 내용을 바탕으로 모든 세부 사항과 질감, 반사, 그림자, 색상 등을 속속 채웁니다”라고 말했습니다.

GAN은 실제 세계에 대한 부족한 이해에도 불구하고 생성자(generator)와 감별자(discriminator)로 이뤄진 네트워크 쌍 구조 덕분에 설득력 있는 결과물을 만들어 낼 수 있습니다. 생성자가 이미지를 만들어 감별자에게 제시하면, 실제 이미지로 트레이닝된 감별자는 합성 이미지의 사실감을 향상하는 방법에 대한 픽셀별 피드백으로 생성자를 지도합니다.

실제 이미지에 대한 트레이닝을 거친 감별자는 실제로 연못이 어떻게 생겼는지 알며, 호수 표면에는 사물이 반사돼 표현된다는 점도 압니다. 생성자는 감별자로부터 설득력 있는 모방을 만들어 내는 법을 배우죠.

또한 사용자는 이 도구를 활용해 생성된 이미지를 특정 화가의 화풍으로 조정하거나 낮 시간 장면을 밤 시간 장면으로 변경하는 스타일 필터를 추가할 수도 있습니다.

브라이언 카탄자로 부사장은 “GauGAN은 다른 이미지에서 가져온 여러 부분을 그저 조합하거나 잘라 붙이기만 하는 단순한 기술이 아닙니다. 오히려 화가가 그림을 그리는 방법과 매우 흡사하게 새로운 이미지를 만들어내는 것이라고 할 수 있죠”라고 설명했습니다.

GauGAN 앱은 육지, 바다, 하늘 등과 같은 자연 요소에 집중하는 한편, 기저에 있는 뉴럴 네트워크는 건물, 도로, 사람 등과 같은 다른 풍경 요소를 채워 넣는 역할을 합니다.

GauGAN 연구 보고서는 오는 6월에 열리는 컴퓨터 비전 · 패턴 인식(CVPR) 콘퍼런스에서 발표를 통해 인정을 받게 돼 있답니다. 5천개 이상의 제출 건 중 인정 받는 건 5%에 불과한데 말이죠.

지난 GPU 기술 컨퍼런스에서 타이탄 RTX GPU로 실행되는 대화형 데모를 활용해 GauGAN을 직접 체험할 수 있는 기회가 제공된 바 있습니다.

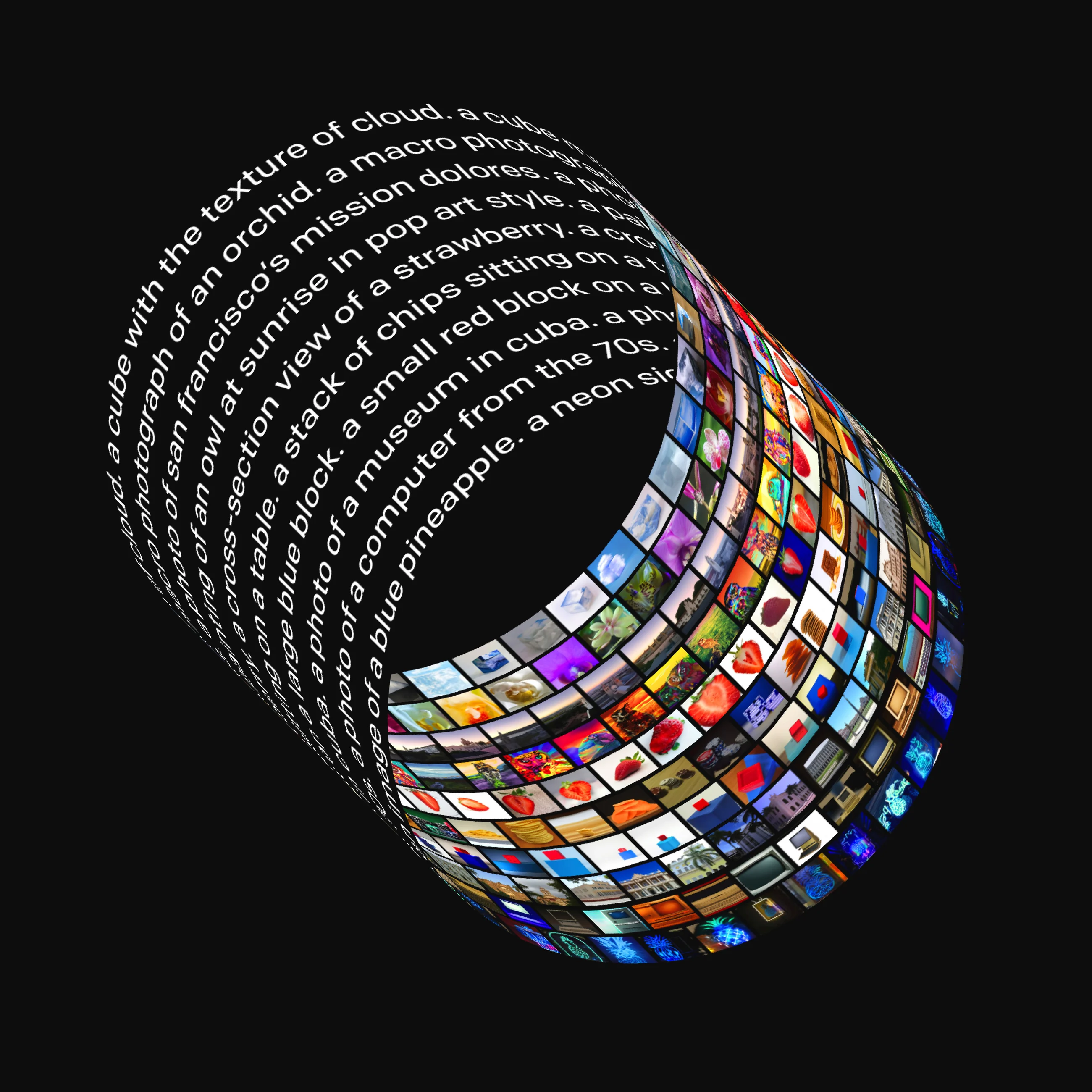

우리는 자연어로 표현 가능한 광범위한 개념에 대해 텍스트 캡션에서 이미지를 생성하는 DALL·E라는 신경망을 훈련시켰습니다.

이미지 생성, 트랜스포머, 생성 모델, DALL·E, GPT-2, 클립, 중요한 단계, 출판, 풀어 주다

DALL·E는 텍스트-이미지 쌍의 데이터세트를 사용하여 텍스트 설명에서 이미지를 생성하도록 훈련된 GPT-3GPT-3의 120억 매개변수 버전입니다. 우리는 동물과 사물의 의인화 버전 생성, 관련 없는 개념을 그럴듯한 방식으로 결합, 텍스트 렌더링, 기존 이미지에 변형 적용 등 다양한 기능 세트가 있다는 것을 발견했습니다.

참조: 4배 더 높은 해상도로 더욱 사실적이고 정확한 이미지를 생성하는 DALL·E 2.

텍스트 프롬프트

개를 산책시키는 투투를 입은 아기 무의 그림

AI 생성 이미지

텍스트 프롬프트

아보카도 모양의 안락의자....

AI 생성 이미지

텍스트 프롬프트

'openai'라는 단어가 적힌 상점 정면....

AI 생성 이미지

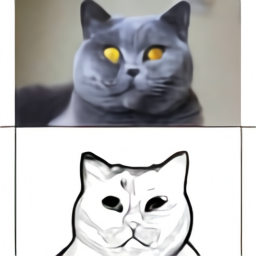

텍스트 프롬프트

위쪽의 고양이는 아래쪽의 스케치와 똑같습니다.

AI 생성 이미지

GPT-3에서는 언어를 사용하여 대규모 신경망에 다양한 텍스트 생성 작업을 수행하도록 지시할 수 있음을 보여주었습니다. Image GPT는 동일한 유형의 신경망을 사용하여 충실도가 높은 이미지를 생성할 수도 있음을 보여주었습니다. 우리는 이러한 발견을 확장하여 언어를 통해 시각적 개념을 조작하는 것이 이제 가능하다는 것을 보여줍니다.

개요

GPT-3과 마찬가지로 DALL·E는 변환기 언어 모델입니다. 최대 1280개의 토큰을 포함하는 단일 데이터 스트림으로 텍스트와 이미지를 모두 수신하고 모든 토큰을 차례로 생성하기 위해 최대 가능성을 사용하여 훈련됩니다.

토큰은 개별 어휘의 기호입니다. 인간의 경우 각 영어 문자는 26자 알파벳의 토큰입니다. DALL·E의 어휘에는 텍스트와 이미지 개념 모두에 대한 토큰이 있습니다. 구체적으로, 각 이미지 캡션은 어휘 크기가 16384인 최대 256개의 BPE 인코딩 토큰을 사용하여 표현되고, 이미지는 어휘 크기가 8192인 1024개의 토큰을 사용하여 표현됩니다.

이미지는 학습 중에 256x256 해상도로 전처리됩니다. VQVAE와 유사합니다. 1,2 각 이미지는 개별 VAE를 사용하여 개별 잠재 코드의 32x32 그리드로 압축됩니다. 삼, 4 지속적인 이완을 사용하여 사전 훈련한 것입니다. 5,6 우리는 완화를 사용한 훈련이 명시적인 코드북, EMA 손실 또는 데드 코드 부활과 같은 트릭의 필요성을 제거하고 큰 어휘 크기로 확장할 수 있다는 것을 발견했습니다.

이 교육 절차를 통해 DALL·E는 처음부터 이미지를 생성할 수 있을 뿐만 아니라 텍스트 프롬프트와 일치하는 방식으로 오른쪽 하단 모서리까지 확장되는 기존 이미지의 직사각형 영역을 재생성할 수도 있습니다.

우리는 생성 모델과 관련된 작업이 중요하고 광범위한 사회적 영향을 미칠 수 있는 잠재력을 가지고 있음을 인식합니다. 앞으로 우리는 DALL·E와 같은 모델이 특정 작업 프로세스 및 직업에 대한 경제적 영향, 모델 결과의 편향 가능성, 이 기술이 암시하는 장기적인 윤리적 문제와 같은 사회적 문제와 어떻게 관련되는지 분석할 계획입니다.

기능

우리는 DALL·E가 언어의 구성 구조를 탐구하는 매우 다양한 문장에 대해 그럴듯한 이미지를 생성할 수 있다는 것을 발견했습니다. 다음 섹션에서는 일련의 대화형 시각적 개체를 사용하여 이를 설명합니다. 비주얼의 각 캡션에 표시된 샘플은 CLIP으로 순위를 다시 매긴 후 512개 중 상위 32개를 선택하여 얻은 것입니다. 그러나 외부에 나타나는 썸네일 및 독립형 이미지 외에는 수동 체리 피킹을 사용하지 않습니다.

자세한 내용은 이후 섹션에서 제공됩니다.

속성 제어

우리는 개체의 여러 속성과 개체가 나타나는 횟수를 수정하는 DALL·E의 능력을 테스트합니다.

텍스트 프롬프트를 편집하거나 더 많은 AI 생성 이미지를 보려면 클릭하세요.

여러 개체 그리기

여러 객체, 객체의 속성, 공간 관계를 동시에 제어하는 것은 새로운 과제입니다. 예를 들어, "빨간 모자, 노란색 장갑, 파란색 셔츠, 녹색 바지를 입은 고슴도치"라는 문구를 생각해 보세요. 이 문장을 올바르게 해석하려면 DALL·E는 동물과 함께 각 의류를 올바르게 구성해야 할 뿐만 아니라 (모자, 빨간색), (장갑, 노란색), (셔츠, 파란색) 및 (바지, 녹색)의 연관성을 형성해야 합니다. ) 섞지 않고

이 작업을 변수 바인딩이라고 하며 문헌에서 광범위하게 연구되었습니다. 7,8,9,10

우리는 상대 위치 지정, 객체 쌓기, 여러 속성 제어를 위해 DALL·E의 기능을 테스트합니다.

DALL·E는 소수의 개체의 속성과 위치에 대해 일정 수준의 제어 가능성을 제공하지만 성공률은 캡션이 어떻게 표현되는지에 따라 달라질 수 있습니다. 더 많은 개체가 도입될수록 DALL·E는 개체와 색상 간의 연관성을 혼동하기 쉽고 성공률이 급격히 감소합니다. 또한 DALL·E는 이러한 시나리오에서 캡션을 바꾸는 것과 관련하여 취약하다는 점에 주목합니다. 즉, 의미상 동일한 캡션은 종종 올바른 해석을 산출하지 못합니다.

원근감과 입체감을 시각화

우리는 DALL·E가 장면의 관점과 장면이 렌더링 되는 3D 스타일을 제어할 수도 있다는 것을 발견했습니다.

이를 더욱 발전시키기 위해 우리는 동일한 간격의 각도 시퀀스에서 각 각도에서 잘 알려진 인물의 머리를 반복적으로 그리는 DALL·E의 능력을 테스트하고 회전하는 머리의 부드러운 애니메이션을 복구할 수 있음을 발견했습니다.

DALL·E는 "어안 렌즈 보기" 및 "구형 파노라마" 옵션에서 볼 수 있듯이 장면에 일부 유형의 광학 왜곡을 적용할 수 있는 것으로 보입니다. 이는 우리가 반사를 생성하는 능력을 탐구하도록 동기를 부여했습니다.

내부 및 외부 구조 시각화

"극단적인 클로즈업 뷰" 및 "X-Ray" 스타일의 샘플을 통해 우리는 단면 뷰로 내부 구조를 렌더링 하고 매크로 사진으로 외부 구조를 렌더링 하는 DALL·E의 능력을 더 깊이 탐구할 수 있었습니다.

상황별 세부정보 추론

텍스트를 이미지로 번역하는 작업은 세부적으로 지정되지 않습니다. 단일 캡션은 일반적으로 무한한 그럴듯한 이미지에 해당하므로 이미지가 고유하게 결정되지 않습니다. 예를 들어, "해가 뜰 때 들판에 앉아 있는 카피바라 그림"이라는 캡션을 생각해 보세요. 카피바라의 방향에 따라 그림자를 그리는 것이 필요할 수도 있지만, 이 세부 사항은 명시적으로 언급되지 않습니다. 세 가지 경우, 즉 스타일, 설정 및 시간 변경; 다양한 상황에서 동일한 대상을 그리는 것; 특정 텍스트가 적힌 객체의 이미지를 생성하는 것입니다.

다양한 수준의 신뢰성을 갖춘 DALL·E는 자연어를 통해 3D 렌더링 엔진 기능의 하위 집합에 대한 액세스를 제공합니다. 이는 소수의 개체의 속성을 독립적으로 제어할 수 있으며 제한된 범위 내에서 개체 수와 개체가 서로 어떻게 정렬되는지 제어할 수 있습니다. 또한 장면이 렌더링 되는 위치와 각도를 제어할 수 있으며 각도 및 조명 조건의 정확한 사양에 따라 알려진 객체를 생성할 수 있습니다.

입력을 명확하고 자세하게 지정해야 하는 3D 렌더링 엔진과 달리 DALL·E는 캡션이 이미지에 명시적으로 명시되지 않은 특정 세부 사항을 포함해야 함을 암시할 때 "빈칸을 채울" 수 있는 경우가 많습니다.

이전 기능의 응용

다음으로, 패션과 인테리어 디자인에 대한 앞선 기능의 활용을 탐구합니다.

관련 없는 개념을 결합

언어의 구성적 특성을 통해 우리는 실제 사물과 상상의 사물을 모두 설명하는 개념을 하나로 묶을 수 있습니다. 우리는 DALL·E가 이질적인 아이디어를 결합하여 물체를 합성하는 능력도 가지고 있다는 것을 발견했는데, 그중 일부는 현실 세계에 존재할 가능성이 거의 없습니다. 우리는 이 능력을 두 가지 사례, 즉 다양한 콘셉트의 특성을 동물에 전달하는 것과 관련 없는 콘셉트에서 영감을 얻어 제품을 디자인하는 것에서 탐구합니다.

동물 일러스트

이전 섹션에서는 실제 물체의 이미지를 생성할 때 관련 없는 개념을 결합하는 DALL·E의 능력을 살펴보았습니다. 여기에서는 동물과 물체의 의인화된 버전, 동물 키메라, 이모티콘 등 세 가지 종류의 일러스트레이션을 위해 예술의 맥락에서 이 능력을 탐구합니다.

제로샷 시각적 추론

GPT-3는 추가 교육 없이 프롬프트에 제공된 답변을 생성하기 위한 설명과 단서만으로 다양한 종류의 작업을 수행하도록 지시받을 수 있습니다. 예를 들어, "여기에 프랑스어로 번역된 'a person walk his dog in the park' 문장이 있습니다."라는 문구가 표시되면 GPT-3는 "un homme qui promène son chien dans le parc"라고 대답합니다. 이 기능을 제로샷 추론이라고 합니다. 우리는 DALL·E가 이 기능을 시각적 영역으로 확장하고 올바른 방식으로 메시지가 표시될 때 여러 종류의 이미지-이미지 변환 작업을 수행할 수 있음을 발견했습니다.

우리는 이 기능이 나타날 것이라고 예상하지 않았으며 이를 장려하기 위해 신경망이나 훈련 절차를 수정하지 않았습니다. 이러한 결과에 힘입어 우리는 20세기에 널리 사용된 시각적 IQ 테스트인 Raven의 진보적 행렬에 대한 테스트를 통해 유추 추론 문제에 대한 DALL·E의 적성을 측정합니다.

지리적 지식

우리는 DALL·E가 지리적 사실, 랜드마크, 인근 지역에 대해 배웠다는 사실을 발견했습니다. 이러한 개념에 대한 지식은 어떤 면에서는 놀라울 정도로 정확하고 다른 면에서는 결함이 있습니다.

시간적 지식

공간에 따라 달라지는 개념에 대한 DALL·E의 지식을 탐구하는 것 외에도 시간에 따라 달라지는 개념에 대한 지식도 탐구합니다.

접근 방식 및 이전 작업 요약

DALL·E는 텍스트와 이미지를 모두 1280개의 토큰(텍스트용 256개, 이미지용 1024개)의 단일 스트림으로 수신하고 모두 자동 회귀적으로 모델링하는 간단한 디코더 전용 변환기입니다. 64개 self-attention 레이어 각각의 주의 마스크를 통해 각 이미지 토큰이 모든 텍스트 토큰에 주의를 기울일 수 있습니다. DALL·E는 레이어에 따라 텍스트 토큰에 대해 표준 인과 마스크를 사용하고 이미지 토큰에 대해 행, 열 또는 컨벌루션 주의 패턴을 사용하는 희소 주의를 사용합니다. 우리는 논문에서 아키텍처 및 교육 절차에 대한 자세한 내용을 제공합니다.

텍스트-이미지 합성은 Reed 등의 선구적인 연구 이후 활발한 연구 분야였습니다. 알, 1111 이 접근 방식은 텍스트 임베딩을 조건으로 한 GAN을 사용합니다. 임베딩은 CLIP과 달리 대비 손실을 사용하여 사전 훈련된 인코더에 의해 생성됩니다. 스택 GAN1212 그리고 StackGAN++13 다중 규모 GAN을 사용하여 이미지 해상도를 확장하고 시각적 충실도를 향상합니다.

AttnGAN14 텍스트와 이미지 특징 사이에 주의를 통합하고 보조 목표로 손실과 일치하는 대조되는 텍스트-이미지 특징을 제안합니다. 이는 오프라인에서 수행되는 CLIP을 사용한 순위 재지정과 비교하면 흥미롭습니다. 기타 업무 15,16,17 이미지 품질을 향상하기 위해 훈련 중에 추가적인 감독 소스를 통합합니다. 마지막으로 Nguyen et. 알 1818 그리고 조 외. 알 1919 사전 학습된 다중 모드 판별 모델을 활용하는 이미지 생성을 위한 샘플링 기반 전략을 탐색합니다.

VQVAE-2에서CLIP을 사용하여 모든 대화형 시각적 개체의 각 캡션에 대해 512개 샘플 중 상위 32개의 순위를 다시 매깁니다. 이 절차는 일종의 언어 기반 검색으로도 볼 수 있습니다. 20,20 샘플 품질에 큰 영향을 미칠 수 있습니다.

각주

- 토큰은 개별 어휘의 기호입니다. 인간의 경우 각 영어 문자는 26자 알파벳의 토큰입니다. DALL·E의 어휘에는 텍스트와 이미지 개념 모두에 대한 토큰이 있습니다. 구체적으로, 각 이미지 캡션은 어휘 크기가 16384인 최대 256개의 BPE 인코딩 토큰을 사용하여 표현되고, 이미지는 어휘 크기가 8192인 1024개의 토큰을 사용하여 표현됩니다.

- 이미지는 학습 중에 256x256 해상도로 전처리됩니다. VQVAE와 유사합니다.1 ,2 각 이미지는 개별 VAE를 사용하여 개별 잠재 코드의 32x32 그리드로 압축됩니다.3 ,4 지속적인 이완을 사용하여 사전 훈련한 것입니다.5 ,6 우리는 완화를 사용한 훈련이 명시적인 코드북, EMA 손실 또는 데드 코드 부활과 같은 트릭의 필요성을 제거하고 큰 어휘 크기로 확장할 수 있다는 것을 발견했습니다. ↩︎

- 자세한 내용은 이후 섹션 에서 제공됩니다 . ↩︎

- 이 작업을 변수 바인딩이라고 하며 문헌에서 광범위하게 연구되었습니다.7 ,8 ,9 ,10↩︎

참고자료

- 반 덴 오드(van den Oord), A., Vinyals, O., Kavukcuoglu, K. (2017). “ 신경 이산 표현 학습 ”. ↩︎ ↩︎

- Razavi, A., van der Oord, A., Vinyals, O. (2019). “ VQ-VAE-2로 다양한 고화질 이미지 생성 ”. ↩︎ ↩︎

- 킹마, 디데릭 P., 맥스 웰링. “ 자동 인코딩 변형 베이 .” arXiv 사전 인쇄(2013). ↩︎ ↩︎

- 레젠데, 다닐로 히메네즈, 샤키르 모하메드, 단 비에스트라. “ 심층 생성 모델의 확률적 역전파 및 근사 추론 .” arXiv 사전 인쇄(2014). ↩︎ ↩︎

- 장이, 구순, 풀, B.(2016). “ Gumbel-softmax를 사용한 범주형 재매개변수화 ”. ↩︎ ↩︎

- 매디슨, C., Mnih, A., Teh, YW (2016). “ 구체적 분포: 이산 확률 변수의 연속적인 완화 ”. ↩︎ ↩︎

- 스몰렌스키, P.(1990). " 텐서 곱 변수 바인딩 및 연결주의 시스템의 상징적 구조 표현 ". ↩︎ ↩︎

- 플레이트, T. (1995). " 홀로그램 축소 표현: 구성 분포 표현을 위한 컨볼루션 대수학 ". ↩︎ ↩︎

- 게일러, R. (1998). “ 곱셈 바인딩, 표현 연산자 및 유추 ”. ↩︎ ↩︎

- 카네르바, P. (1997). “ 완전 분산 표현 ”. ↩︎ ↩︎

- 리드, S., Akata, Z., Yan, X., Logeswaran, L., Schiele, B., Lee, H. (2016). “ 생성적 적대적 텍스트를 이미지 합성으로 ”. ICML 2016에서 . ↩︎

- Zhang, H., Xu, T., Li, H., Zhang, S., Wang, X., Huang X., Metaxas, D. (2016). " StackGAN: 누적된 생성적 적대 네트워크를 사용하여 텍스트를 사실적인 이미지 합성으로 변환합니다 ." ICCY 2017에서 . ↩︎

- Zhang, H., Xu, T., Li, H., Zhang, S., Wang, X., Huang, X., Metaxas, D. (2017). " StackGAN++: 누적된 생성적 적대 신경망을 사용한 사실적인 이미지 합성 ". IEEE TPAMI 2018에서. ↩︎

- Xu, T., Zhang, P., Huang, Q., Zhang, H., Gan, Z., Huang, X., He, X. (2017). " AttnGAN: 주의 생성 적대 네트워크를 사용하여 세분화된 텍스트에서 이미지까지 생성합니다 . ↩︎

- 리드, S., Akata, Z., Mohan, S., Tenka, S., Schiele, B., Lee, H. (2016). “ 무엇을 어디서 그릴지 배우기 ”. NIPS 2016에서 . ↩︎

- Li, W., Zhang, P., Zhang, L., Huang, Q., He, X., Lyu, S., Gao, J. (2019). " 적대적 훈련을 통한 객체 중심의 텍스트-이미지 합성 ". CVPR 2019에서.

- ↩︎고재윤, Baldridge, J., 이혜화, 양용영(2020). “ 세밀한 사용자 관심을 기반으로 한 텍스트-이미지 생성 ”. WACV 2021에서.

- ↩︎Nguyen, A., Clune, J., Bengio, Y., Dosovitskiy, A., Yosinski, J. (2016). “ 플러그 앤 플레이 생성 네트워크: 잠재 공간에서 이미지의 조건부 반복 생성 .

- ↩︎Cho, J., Lu, J., Schwen, D., Hajishirzi, H., Kembhavi, A. (2020). " X-LXMERT: 다중 모달 변환기를 사용하여 페인트, 캡션 및 질문 답변 ". EMNLP 2020.

- ↩︎안드레아스, J., 클라인, D., 레빈, S. (2017). “ 잠재언어로 학습하기 ”.

'say와 AI 챗봇친구 만들기 보고서' 카테고리의 다른 글

| 가짜 정보 줄이고 언어 표현 순화한 GPT-4 새 버전 나왔다 (1) | 2023.08.31 |

|---|---|

| NVIDIA AI GauGAN으로 몇 초안에 스케치를 사실적 풍경으로 탄생 (0) | 2023.08.31 |

| 오늘 밤 희귀한 슈퍼 블루문을 한창으로 볼 수 있는 정확한 시간입니다 (2) | 2023.08.30 |

| SKT, 보안통신 표준 개발 [양자컴퓨터, 현재 암호 체계 무력화시켜… ] (1) | 2023.08.30 |

| 클라우드옵스 [클라우드의 가치를 100% 실현한다] (0) | 2023.08.30 |